处理装置、处理方法及记录介质

文献发布时间:2023-06-19 11:26:00

本申请是申请日为2019年5月10日、申请号为201910388236.X、发明名称为“策略搜索装置、方法及记录介质”的发明专利申请的分案。

技术领域

本发明涉及根据状况搜索有效的策略的技术。

背景技术

在各种领域中,利用机械学习、根据状况搜索并提示有效的策略的技术受到关注。在专利文献1-4中,公开了使用强化学习的方法来学习使想要提高的指标(以下也称作“KPI”)提高的有效策略的技术。KPI是Key Performance Indicator(关键绩效指标)的简写。

专利文献1所公开的技术涉及如下方法:作为进行强化学习时的环境模型而使用已经经历的事件和行动的对的集合,由此降低强化学习的计算成本。

专利文献2所公开的技术涉及如下方法:在强化学习中使用的价值函数的神经网络下的近似中,即使输入变量是许多个,也能够高精度且低成本地对神经网络的权重进行学习。

专利文献3所公开的技术涉及如下方法:在用来在汽车的驾驶时提示支援驾驶者的信息的系统中,利用强化学习制作良好驾驶的行动指南,此时根据周边环境的变化对可采取的行动进行限定,由此有效地开展强化学习。

专利文献4所公开的技术涉及如下方法:在强化学习中,利用相关分析来缩减接下来应采取的行动的候选,有效地学习机器人控制的方法。

专利文献1:日本特开2010-73200号公报

专利文献2:日本特开2009-64216号公报

专利文献3:日本特开2004-348394号公报

专利文献4:日本特开2018-24036号公报

提出了利用最优解搜索及预测等技术向人提示与状况匹配的有效的行动来支援人的意思决定的机制。在最优解搜索中,表示最优性的数值基本上必须限定于1个。但是,实际上应注意的KPI是多个,或想要重视的KPI因人而异的情况较多。但是,没有与像这样按每个用户而嗜好不同的多个KPI对应地搜索有效的行动的方法。

发明内容

本发明的目的是提供一种在存在多样指标的环境中根据状况而搜索适当的策略的技术。

本发明的1个技术方案的处理装置,具备:第1处理部,进行对对象环境适用了规定的行动时的状态转变的模拟,计算状态转变后的上述对象环境的状态、以及利用第1指标求出的对所适用的上述行动的评价值;以及第2处理部,基于表示针对上述对象环境的状态的行动的价值的价值函数,选择行动并输入至上述第1处理部,并且基于由上述第1处理部计算出的上述状态和上述评价值,更新上述价值函数;在上述第2处理部中,基于第2指标,选定上述第1处理部中的模拟结果,并且基于所选定的模拟结果和上述价值函数,决定策略。

发明效果

根据本发明的1个技术方案,指定应提高的第1指标和与其不同的第2指标,在价值函数的学习中重视该第2指标来进行策略的搜索,所以在存在多样指标的环境中能够根据状况选择优选的策略。

附图说明

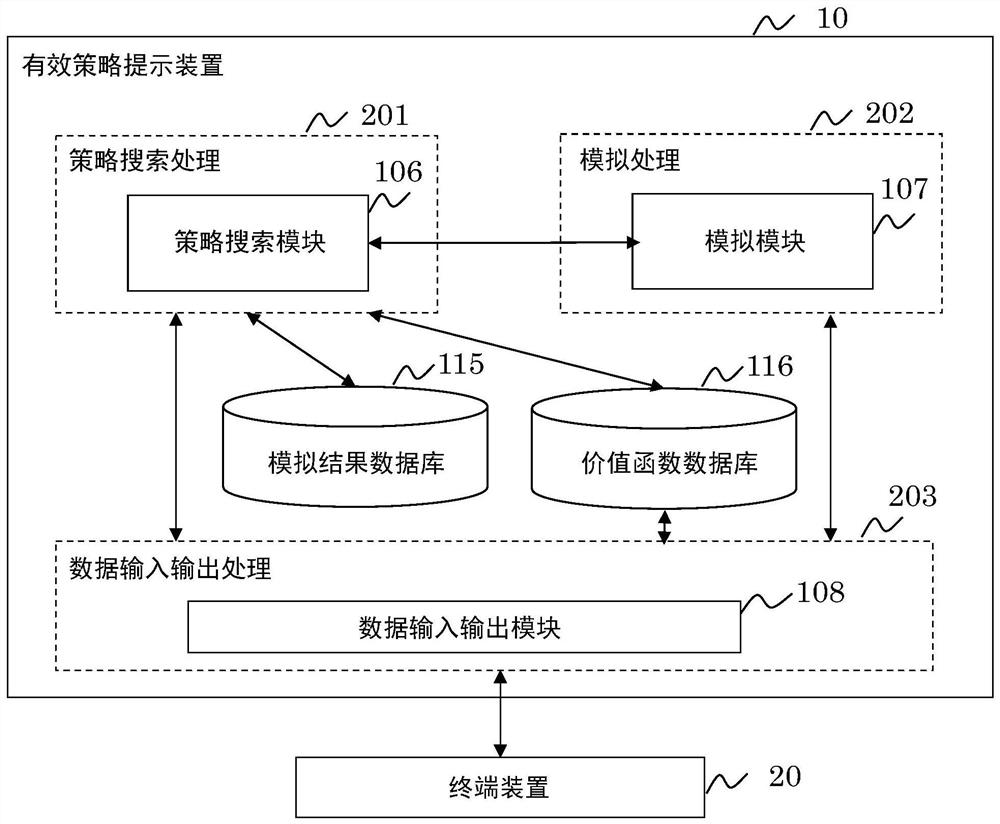

图1是有效策略提示装置的框图。

图2是有效策略提示装置的处理结构图。

图3是强化学习处理的流程图。强化学习处理是强化学习程序110执的处理。

图4是KPI管理处理的流程图。

图5是情节末端处理的流程图。

图6是KPI兼顾可否判断处理的流程图。

图7是模拟处理的流程图。

图8是表示用户输入画面的图。

图9是表示有效策略提示画面的图。

图10是表示储存在价值函数数据库中的价值函数数据的一例的图。

图11是表示储存在模拟结果数据库中的模拟结果的一例的图。

图12是学习结果利用处理的流程图。

附图标记说明

10…有效策略提示装置;20…终端装置;80…用户输入画面;90…有效策略提示画面;101…CPU;102…存储器;103…通信装置;104…程序存储装置;105…数据存储装置;106…策略搜索模块;107…模拟模块;108…数据输入输出模块;110…强化学习程序;111…KPI管理程序;112…模拟结果选择程序;113…报酬计算函数群;114…KPI兼顾可否判断程序;115…模拟程序;116…模拟结果数据库;117…价值函数数据库;201…策略搜索处理;202…模拟处理;203…数据输入输出处理;801…KPI栏;802…最优先选择栏;803…重要选择栏;804…制定计划按钮;901…策略;902…策略;1001…模拟数据。

具体实施方式

参照附图对有效策略提示装置的实施方式进行说明。有效策略提示装置是将存在多样指标的环境作为搜索有效的策略的对象,根据用户的嗜好等的状况搜索优选的策略并向用户提示的装置。策略是为了使对象环境改善而用户应采取的行动。行动是与对象环境关联的行为,能够使对象环境的状态转变。如果对象环境的状态转变,则表示对象环境的某个指标的值变化。

图1是有效策略提示装置的框图。图2是有效策略提示装置的处理结构图。

参照图1,有效策略提示装置具有CPU(Central Processing Unit)101、存储器102、通信装置103、程序存储装置104和数据存储装置105。

程序存储装置104是可写入及读出地存储数据的装置,存储有策略搜索模块106、模拟模块107和数据输入输出模块108。策略搜索模块106、模拟模块107及数据输入输出模块108分别是软件模块。软件模块由1个以上的软件程序构成,是实现某有连贯的功能的软件零件。

另外,本实施方式所示的软件模块的结构及软件模块的软件程序的结构是一例。只要作为装置整体而提供希望的功能,则在装置内部将软件模块及软件程序以怎样的功能分担来设计都可以。

策略搜索模块106是执行图2所示的策略搜索处理201的软件模块,包括强化学习程序110、KPI管理程序111、模拟结果选择程序112及报酬(Reward)计算函数群113。强化学习程序110、KPI管理程序111、模拟结果选择程序112及报酬计算函数群113分别是软件程序。软件模块及各软件程序的处理后述。

模拟模块107是执行图2所示的模拟处理202的软件模块,包括作为软件程序的模拟程序115。模拟模块107及模拟程序115的处理在后面叙述。

数据存储装置105是可写入及读出地存储数据的装置,存储模拟结果数据库116及价值函数数据库117。

另外,这里表示了使程序存储装置104和数据存储装置105为独立的装置的例子,但并不限定于该结构。程序存储装置104和数据存储装置105也可以由同一个装置兼任。

CPU101是将作为主存储器的存储器102作为工作区来利用,一边读出存储在数据存储装置105中的数据并将运算过程或运算结果的数据向数据存储装置105写入,一边执行存储在程序存储装置104中的各软件的处理器。

通信装置103将由CPU101处理后的信息经由包括有线、无线或它们两者的通信网络发送,并且将经由通信网络接收到的信息向CPU101传递。由此,例如能够从外部的终端利用有效策略提示装置10。

如上述那样,并且如图2所示,有效策略提示装置10如果被从用户指定1个最优先指标(以下也称作“最优先KPI”)和在最优先KPI以外的指标中重要的1个以上的指标(以下也称作“重要KPI”),则通过使策略搜索处理201与模拟处理202协同,搜索在考虑重要KPI的同时使最优先KPI提高的策略并提示。由此,在存在多样的指标的状况下,能够搜索与状况对应的优选的策略。

模拟处理202是模拟模块107执行的处理。在模拟处理202中,CPU101对于对象环境适用行动而对对象环境的状态转变进行模拟,作为模拟结果而计算转变后的对象环境的状态、以及由最优先KPI(第1指标)表示的与所适用的行动对应的报酬。

策略搜索处理201是策略搜索模块106执行的处理,使用通常的强化学习的方法。在本说明书中,通过使用被称作DQN(Deep Q Network)的强化学习方法的处理进行说明。在DQN中,通过神经网络,构成以表示对象环境的状态的数值向量为输入、以对于状态的行动的价值(也称作“Q值”)为输出的价值函数。也有将该价值函数的神经网络称作DQN的情况。在本说明书中,以下将价值函数的神经网络称作DQN。在策略搜索处理201中,CPU101执行反复多次进行以下的一系列处理的情节(episode):基于表示针对对象环境的状态的行动的价值的DQN,选择行动,适用所选择的行动,通过模拟处理202对对象环境的状态转变进行模拟,取得转变后的对象环境的状态和与所适用的行动对应的报酬,基于该状态和报酬将DQN更新。进而,CPU101将重要KPI(第2指标)满足规定的条件的情节的数据储存到模拟结果数据库116,基于到此为止储存的情节将DQN改善。学习结果的DQN被保存到价值函数数据库117中。CPU101反复进行从该情节的执行到DQN的改善为止的一系列的处理直到满足规定的结束条件,将基于所得到的DQN而决定的策略进行提示。

在图2中,数据输入输出处理203是数据输入输出模块108执行的处理,是进行由用户操作的终端装置20和有效策略提示装置10的数据的输入输出的处理。例如,在数据输入输出处理203中,CPU101受理将对象的环境进行仿真的数据的输入,传递给进行模拟处理202的模拟模块107。此外,CPU101受理最优先KPI及重要KPI的指定,传递给策略搜索模块106。

如以上说明,根据本实施方式,由于指定与应提高的第1指标不同的第2指标,在价值函数的学习中重视该第2指标而进行策略的搜索,所以在存在多样指标的环境中通过指定第1指标及第2指标,能够根据状况来搜索优选的策略。

以下,对各软件模块及软件程序的处理进行说明。

图3是强化学习处理的流程图。强化学习处理是强化学习程序110执的处理。

参照图3,CPU101将DQN(价值函数)初始化(步骤S301)。DQN所表示的价值函数通过参数Θ被赋予特征。DQN的初始化是将该参数Θ设定为规定的默认值的处理。

接着,CPU101设定初始状态作为在模拟中将对象环境进行仿真的数据的状态(步骤S302)。

接着,CPU101,作为情节的1个时间步骤(以下也简单称作“步骤”)而选择在模拟中适用的行动(动作a)(步骤S303)。例如,CPU101为了试行错误,基于DQN而选择Q值为最高值的行动或选择Q值为一定值以上的行动。

接着,CPU101适用所选择的行动,使对象环境的状态转变,计算下一个状态s和与该行动对应的报酬r(步骤S304)。其将模拟推进1个步骤。

接着,CPU101基于该状态s和报酬r将DQN更新(步骤S305)。DQN的更新通过将参数Θ更新以使得得到较高的报酬r的行动a的Q值提高来进行。

接着,CPU101判定是否达到了情节的末端(步骤S306)。例如,在最优先KPI的值达到了目标值的情况下、或执行了规定步骤次数的情况下判断为情节的末端就可以。如果不是情节的末端,则CPU101返回到步骤S303,选择接下来适用的行动。

如果是情节的末端,则CPU101接着执行情节末端处理(步骤S307)。情节末端处理是将满足规定的条件的情节的一系列的模拟结果向数据库保存的处理。情节末端处理的详细情况后述。

接着,CPU101判定是否满足了强化学习处理的结束条件(步骤S308)。例如,也可以在达到了情节执行次数或步骤执行次数的上限值的情况下判定为结束。如果不满足结束条件,则CPU101返回到步骤S302,使对象环境的状态回到初始状态,开始下一个情节。如果满足结束条件,则CPU101结束强化学习处理。

图4是KPI管理处理的流程图。KPI管理处理是由KPI管理程序111执行的处理,是根据用户输入的最优先KPI及重要KPI进行通过DQN的强化学习的策略搜索、将学习结果记录的处理。

参照图4,CPU101首先从数据输入输出模块108取得用户输入的最优先KPI及重要KPI(步骤S401)。

接着,CPU101取得与最优先KPI对应的报酬计算函数(步骤S402)。只要预先设定根据最优先KPI(第1指标)计算报酬的报酬计算函数、将函数的数据作为报酬计算函数群113保存、基于数据输入输出模块108受理了输入的最优先KPI来选择与其对应的报酬计算函数就可以。由于预先设定有根据第1指标计算报酬的报酬计算函数,所以如果第1指标决定,则能够容易地决定报酬的计算方法。

接着,CPU101指定所选择的报酬计算函数、最优先KPI和重要KPI,使强化学习程序110执行强化学习处理(步骤S403)。从强化学习程序110作为学习结果而得到DQN。

接着,CPU101将学习结果的DQN的参数与最优先KPI及重要KPI建立关联,作为价值函数数据向价值函数数据库117保存(步骤S404)。图10是表示储存在价值函数数据库中的价值函数数据的一例的图。参照图10,作为价值函数数据,将作为最优先KPI的识别信息的最优先KPI ID、作为重要KPI的识别信息的重要KPI ID、以及对价值函数赋予特征的价值函数参数建立对应而记录。例如,表示了通过使用最优先KPI ID为1的最优先KPI和重要KPIID为3的重要KPI的强化学习得到的DQN的价值参数是Θ1。此外,表示了通过使用最优先KPIID为1的最优先KPI和重要KPI ID为5的重要KPI的强化学习得到的DQN的价值参数是Θ2。

图5是情节末端处理的流程图。情节末端处理是由模拟结果选择程序112执行的处理,是相当于图3的步骤S307的处理。

参照图5,CPU101首先取得达到了末端的情节的模拟结果的数据(步骤S501)。能够从该数据取得该情节的最终的各指标的值。接着,CPU101根据模拟结果的数据取得重要KPI的值,评价该值是否满足规定的条件(步骤S502)。

接着,如果重要KPI满足规定的条件,则CPU101将该情节的模拟结果向模拟结果数据库116保存(步骤S503)。例如如果重要KPI超过了阈值则设为满足条件就可以。达到了末端的情节由于最优先KPI达到了目标值或最优先KPI的提高收敛,所以这里将重要KPI用于评价。也可以将最优先KPI的更严格的条件用于情节选择的评价。

图11是表示储存在模拟结果数据库中的模拟结果的一例的图。参照图11,在模拟数据1001中,将作为情节的识别信息的情节ID、作为各步骤的识别信息的时间步骤、表示该步骤的行动前的状态的事前状态s、表示在该步骤中适用的行动的动作a、表示与该动作对应的报酬的报酬r和表示该步骤的行动后的状态的事后状态s’建立对应,作为1个条目(图11的1行)记录。在1个情节中包含各个步骤的多个条目。

例如,在开头的条目中表示:在情节ID=1的情节中的时间步骤=1的步骤中,对象环境从事前状态s=s1的状态,通过动作a=a3的行动,转变为事后状态s’=s2的状态,针对该行动得到了报酬r=r1的报酬。在下一个条目中表示:在情节ID=1的情节中的时间步骤=2的步骤中,对象环境从事前状态s=s2的状态,通过动作a=a12的行动,转变为事后状态s’=s3的状态,针对该行动得到了报酬r=r2的报酬。

在本实施方式中,与强化学习程序110执行强化学习处理并行地,KPI兼顾可否判断程序114执行KPI兼顾可否判断处理。图6是KPI兼顾可否判断处理的流程图。

参照图6,CPU101首先取得所执行的情节的模拟结果(步骤S601)。由于并行进行强化学习处理,所以随着强化学习进展,在步骤S601中取得的模拟结果增加。在该KPI兼顾可否判断程序114中,不仅使用在情节末端处理中满足了规定条件的情节的模拟结果,也可以还使用不满足规定条件的情节的模拟结果。

接着,CPU101计算所取得的模拟结果的最优先KPI及重要KPI,储存最优先KPI与重要KPI的组合的数据(步骤S602)。如果已经计算了最优先KPI及重要KPI,则只要取得该值就可以。

接着,CPU101使用所储存的数据,计算最优先KPI和重要KPI的相关系数(步骤S603)。由于如上述那样随着强化学习进展而模拟结果增加,所以随之而最优先KPI与重要KPI的相关也显著化。

接着,CPU101判定计算出的相关系数是否是负值(步骤S604)。如果相关系数为负,则CPU101输出警告最优先KPI和重要KPI是具有相互相反的特性的指标的警报(步骤S605)。最优先KPI和重要KPI具有相互相反的特性,是指如果将一方改善则另一方恶化的关系。由于这样的最优先KPI和重要KPI的设定有可能不适当,所以将该消息提示给用户,有可能带来重新评估的机会。

这样,策略搜索模块106的KPI兼顾可否判断程序114计算被反复执行的多个情节中的最优先KPI与重要KPI的相关系数,如果该相关系数为负则提示警告。在推进学习的过程中,如果使最优先KPI提高则使重要KPI下降的关系显著化的情况下,通过警告来提示该情况,能够有助于不能兼顾的指标的组合的指定的重新评估等。

此外,KPI兼顾可否判断程序114也可以与通过强化学习程序110的情节的执行而开展的强化学习并行地计算相关系数,在判断为相关系数为负的阶段,使强化学习结束。能够减少指定了不能兼顾的最优先KPI与重要KPI的组合的无用的学习处理。

图7是模拟处理的流程图。模拟处理是由模拟模块107的模拟程序115执行的处理。模拟模块107根据来自强化学习程序110的指示而执行模拟处理。

参照图7,CPU101首先输入强化学习程序110所选择的行动(动作a)(步骤S701)。接着,CPU101适用被输入的行动而模拟对象环境的1个步骤的状态转变(步骤S702)。接着,CPU101输出执行了1个步骤的模拟之后的对象环境的状态s和与所适用的行动对应的报酬r的信息(步骤S703)。这里所输出的状态s和报酬r的信息被提供至强化学习程序110。

图8是表示用户输入画面的图。用户输入画面80是用于用户指定最优先KPI及重要KPI而执行策略搜索的画面。

在用户输入画面80中,在KPI栏801显示有对象环境的各指标的一览。在用户输入画面80中,还显示有用来指定最优先KPI的最优先选择栏802、用来指定重要KPI的重要选择栏803和用来开始策略搜索的制定计划按钮804。

在最优先选择栏802中,有与可指定为最优先KPI的KPI对应的选择栏。在重要选择栏803中有与可指定为重要KPI的KPI对应的选择栏。在图8的例子中,作为最优先KPI而选择了“资产停用次数”这样的指标。此外,作为重要KPI而选择了“维护次数”这样的指标和“更换零件费”这样的指标。如果在该选择状态下对制定计划按钮804进行操作,则有效策略提示装置10执行将最优先KPI设为“资产停用次数”、将重要KPI设为“维护次数”和“更换零件费”的策略搜索。

图9是表示有效策略提示画面的图。有效策略提示画面90是用来向用户提示策略搜索的结果的画面。作为策略搜索的结果而在有效策略提示画面90上提示策略901、902。在图9中,表示了在从图8的选择状态操作了制定计划按钮804的情况下显示的有效策略提示画面90的例子。

在本实施方式中,可以对多个重要KPI通过加权来设置权重而搜索策略。当以保留多个重要KPI全都满足规定条件的情节的方式推进强化学习时,只要选择与权重较小的重要KPI相比更优先地良好维持权重较大的重要KPI那样的情节就可以。

在图8的例子中,指定了“维护次数”和“更换零件费”这2个重要KPI。在图9的例子中,显示有使“维护次数”的权重较大的策略901和使“更换零件费”的权重较大的策略902。

策略901是重视维护次数的情况下的策略例。在策略901的雷达图中,更换零件费比较高。这意味着通过在更换零件中使用寿命长的昂贵的零件,不增加维护次数而抑制资产停用次数的策略。用户如果想要以不怎么增加维护次数的策略将资产停用次数抑制得较少,则只要采用策略901就可以。

策略902是重视更换零件费的情况下的策略例。在策略902的雷达图中,维护次数比较高。这意味着通过增加维护频度,不使用昂贵的更换零件而抑制资产停用次数的策略。如果用户想要以不怎么增加更换零件费的策略将资产停用次数抑制得较少,则只要采用策略902就可以。

另外,在本实施方式中,假设有效策略提示装置10选择多个重要KPI、对于各个选择提示优选的策略,但也可以是其他结构。例如,也可以是用户指定对于多个重要KPI的权重,根据该指定来提示优选的策略。在此情况下,数据输入输出模块108还受理多个重要KPI的权重的输入。策略搜索模块106只要选择将权重较大的重要KPI比权重较小的重要KPI更优先地维持为良好的值的情节来推进学习就可以。用户能够对多个重要KPI进行加权,搜索更符合嗜好的策略。

此外,在本实施方式中,假设当用户指定最优先KPI和重要KPI而执行策略搜索时,将价值函数的参数Θ初始化为规定的默认值而开始处理,但也可以是其他结构。如果由数据输入输出模块108受理了输入的最优先KPI是在过去的策略搜索中作为重要KPI的指标,则策略搜索模块106也可以使用通过该过去的策略搜索得到的价值函数作为此次策略搜索中的价值函数的初始值。通过利用过去的策略搜索的学习结果作为初始值,能够期待价值函数的学习所需要的时间的缩短。

图12是学习结果利用处理的流程图。学习结果利用处理是强化学习程序110代替强化学习处理的步骤S301而作为变形例执行的处理。

参照图12,CPU101首先判定最优先KPI是否为在过去实施的策略搜索的强化学习中设为重要KPI的KPI(步骤S121)。如果最优先KPI是过去的重要KPI,则CPU101将通过以该最优先KPI为重要KPI的强化学习得到的价值函数的参数Θ设定为此次的价值函数的初始值(步骤S122)。如果最优先KPI不是过去的重要KPI,则CPU101将规定的默认值设定为此次的价值函数的初始值(步骤S123)。

上述的本发明的实施方式是用于本发明的说明的例示,并不将本发明的范围仅限定于这些实施方式。本领域技术人员不脱离本发明的范围而能够以其他的各种形态实施本发明。

- 数据处理装置、数据处理方法、程序、程序记录介质、数据记录介质和数据结构

- 数据处理装置和数据处理方法、程序和程序记录介质、数据记录介质和数据结构