一种面向独居人群的机器人智能情绪识别治愈方法

文献发布时间:2023-06-19 11:29:13

技术领域

本发明涉及宠物机器人,特别涉及一种面向独居人群的机器人智能情绪识别治愈方法。

背景技术

随着社会的发展,现如今空巢老人与独居青年人数持续上涨,独居人群长时间缺少照顾和陪伴,易感到孤独,也可能出现多种心理问题;而养宠物虽然能给人们陪伴感,但也存在太多限制,随着生活节奏的加快和生活方式的改变,养宠物反而可能成为一种负担。随着科技的发展,电子宠物机器人也逐步应运而生,但目前智能电子宠物大多停留在人机交互层面,交互生硬,给使用者带来的陪伴感不强,用户体验不佳,还有待改进的空间。

发明内容

本发明的目的是提供一种面向独居人群的机器人智能情绪识别治愈方法,能智能地对使用者进行情绪监测,可直接进行交互治愈陪伴,更加智能、实用。

本发明的上述技术目的是通过以下技术方案得以实现的:

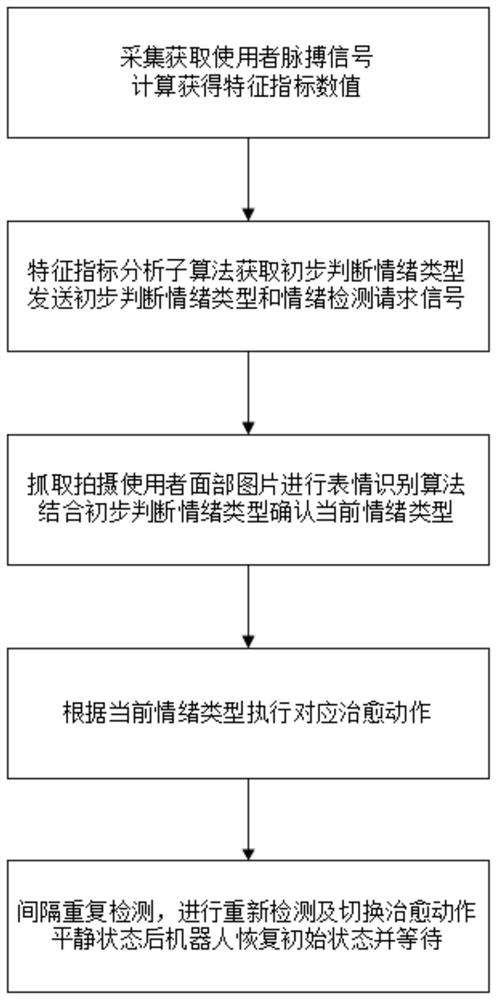

一种面向独居人群的机器人智能情绪识别治愈方法,包括有以下步骤:

S1、使用者佩戴手环,手环的生理特征检测模块实时采集获取使用者的脉搏信号,并根据脉搏信号计算设定的特征指标;

S2、手环进行实时采集监测,当检测到使用者脉搏信号中设定特征指标超出平静状态下基准阈值时,通过特征指标分析子算法获取使用者初步判断情绪类型,并发送初步判断情绪类型信息和情绪检测请求信号至机器人本体;

S3、机器人本体的本体主控模块接收获取手环发送的情绪检测请求信号,启动机器人本体寻找使用者并通过摄像头抓取拍摄使用者面部图片,进行表情识别算法,根据表情识别结果匹配设定的识别情绪类型,并结合初步判断情绪类型信息确认使用者当前情绪类型;

S4、机器人本体根据确认的使用者当前情绪类型,调用并执行对应治愈动作;

S5、间隔设定时长周期性进行特征指标分析判断,若判定情绪类型维持,则持续执行治愈动作;若判定的情绪类型变化,则重新进行表情识别算法并切换执行对应治愈动作;若检测到使用者恢复平静状态时,机器人恢复至初始状态,以等待下一次表情识别及执行对应治愈动作。

作为优选,综上所述,本发明具有以下有益效果:

通过手环实时对使用者的脉搏信号进行采集监测,能及时对使用者的情绪进行初步判断,并且在检测到情绪出现非平静状态时,能及时的再次通过机器人本体对使用者情绪类型进行二次识别确认;机器人本体能寻找跟随使用者并通过表情识别算法确认情绪后,能智能的进行交互陪伴,执行对应治愈动作,实现智能、自动的检测及交互,无需使用者发出指令后进行才可交互,能增强陪伴感和体验感。

附图说明

图1为本方法的流程示意框图;

图2为检测确认使用者情绪类型的具体流程示意图;

图3为人形轮廓宽度变化趋势示意图;

图4为人形轮廓判别流程图;

图5为机器人本体寻找跟随使用者的运动流程示意图。

具体实施方式

以下结合附图对本发明作进一步详细说明。

根据一个或多个实施例,公开了一种面向独居人群的机器人智能情绪识别治愈方法,如图1所示,包括有以下步骤:

S1、使用者佩戴手环,手环的生理特征检测模块实时采集获取使用者的脉搏信号,并根据脉搏信号计算设定的特征指标;

S2、手环进行实时采集监测,当检测到使用者脉搏信号中设定特征指标超出平静状态下基准阈值时,通过特征指标分析子算法获取使用者初步判断情绪类型,并发送初步判断情绪类型信息和情绪检测请求信号至机器人本体;

S3、机器人本体的本体主控模块接收获取手环发送的情绪检测请求信号,启动机器人本体寻找使用者并通过摄像头抓取拍摄使用者面部图片,进行表情识别算法,根据表情识别结果匹配设定的识别情绪类型,并结合初步判断情绪类型信息确认使用者当前情绪类型;

S4、机器人本体根据确认的使用者当前情绪类型,调用并执行对应治愈动作;

S5、间隔设定时长周期性进行特征指标分析判断,若判定情绪类型维持,则持续执行治愈动作;若判定的情绪类型变化,则重新进行表情识别算法并切换执行对应治愈动作;若检测到使用者恢复平静状态时,机器人恢复至初始状态,以等待下一次表情识别及执行对应治愈动作。

其中,步骤S1中,佩戴的手环持续采集获取使用者PPG波形,为带有噪声的脉搏信号,需要对采集带噪脉搏信号进行去噪处理。

对采集到的脉搏PPG波形使用bior3.5作为小波基进行离散小波变换,将脉搏PPG波形做8层分解后获得含有噪声的小波系数ω;

在高频小波系数中设λ为阈值进行量化,若高频小波系数大于λ,则将该小波系数缩小一个单位,对于小于λ的小波系数将其归零;

其中N为数据长度,σ为噪声标准差;

将量化后的小波系数逆小波变化得到去噪后的波形,得到去噪后的脉搏信号。

PPG波形中一阶差分信号表现为过零点,二阶差分信号表现为极小值。设f(n)为脉搏信号序列,s

根据去噪获取的脉搏信号,计算求取脉搏信号的一阶和二阶的差分序列,根据波峰一阶差分过零点和二阶差分极小值的出现相对应的特点,再满足两次波峰之间的时间差大于450ms,小于1150ms与相邻波峰的两个波峰的峰值,后者的电压变化量不能大于前一个波峰峰值的50%的条件,确定有效波峰。

设定一个波段的P-P间期序列为T=[t

计算对应特征指标,特征指标包括有:

P-P区间的平均值MEAN、波段平均心率H_R、电压序列均值V_Mean、电压序列最大值V_Max、电压序列最小值V_Min、电压序列中值V_Middle、电压序列标准差V_SDNN;

具体计算公式如下:

P-P区间的平均值:

波段平均心率:

电压序列均值:

电压序列最大值:V_Max=MAX(V);

电压序列最小值:V_Min=MIN(V);

电压序列中值:V_Middle=MIDDLE(V);

电压序列标准差:

使用者佩戴手环可实时采集脉搏信号进而可计算获得对应实时特征指标。

具体的,步骤S2中,对通过特征指标分析子算法获取使用者初步判断情绪类型,根据每个使用者的基准特征指标数值的差异,需要根据使用者进行基准的设定,通过手环在使用者平静状态下进行采集并将平静状态下计算获取的特征指标作为使用者的基准特征指标,进行存储后,用于后续的分析。

若某一时间段监测到使用者的特征指标MEAN>平静状态下的MEAN数值,且特征指标H_R<平静状态下的H_R数值,则执行特征指标情绪分析子算法。

特征指标分析子算法通过对比实时特征指标与基准特征指标,进行使用者情绪的初步判断:

若实时特征指标电压序列均值V_Mean小于基准特征指标的V_Mean数值,实时特征指标V_Min小于基准特征指标的V_Min数值,实时特征指标V_Middle小于基准特征指标的V_Middle数值,则初步判断情绪类型为高兴;

若实时特征指标电压序列均值V_Mean大于基准特征指标的V_Mean数值,实时特征指标V_Min大于基准特征指标的V_Min数值,实时特征指标V_Middle大于基准特征指标的V_Middle数值,实时特征指标V_Max大于基准特征指标的V_Max数值,实时特征指标V_SDNN大于基准特征指标的V_SDNN数值,则初步判断情绪类型为悲伤;

若实时特征指标电压序列均值V_Mean大于基准特征指标的V_Mean数值,实时特征指标V_Min大于基准特征指标的V_Min数值,实时特征指标V_Middle大于基准特征指标的V_Middle数值,实时特征指标V_Max大于基准特征指标的V_Max数值,实时特征指标V_SDNN小于基准特征指标的V_SDNN数值,则初步判断情绪类型为恐惧。

如图2所示,当手环采集初判出对应情绪类型时,输出初步判断情绪类型信息,并且同时发送情绪检测请求信号至机器人本体上,以请求机器人本体对使用者当前情绪进行进一步检测确认,以便于进行对应治愈陪伴。

机器人本体接收到情绪检测请求信号后,启动机器人本体进行寻找使用者并进行表情识别算法进行二次检测分析使用者情绪。

机器人本体通过摄像头拍摄获取使用者面部图片,通过卷积神经网络模型训练获取面部表情识别机对使用者面部图片进行情绪识别分类,面部表情是由五官以及肌肉的变化所引起的,根据Hess、Blais、Eisenbarth等人的研究实验表明:眼部和嘴部在面部表情识别中占有主导性的作用,并且在不同表情中所起的作用不同,因此对每一张有表情标签的图像分别获取不同焦点数据,构建卷积神经网络模型,采用面部区域、眼部区域、嘴部区域三个渠道将不同焦点图像分别输入网络进行特征提取和表情识别,最后,采用基于决策层的融合技术将三个渠道的识别结果进行相对多数投票决策,获取整体最优识别率。

面部识别:对给定图片进行扫描,判断是否存在面部,框选图片中提取面部区域,再次提取眼部区域与嘴部区域,剔除非人脸区域;

眼部表情特征识别:根据眼部ROI比例因子进行识别判断,分别为包括有X

开心:1.眉毛略微下弯;2.下眼睑出现皱纹,外眼角出现鱼尾纹并向外扩张;

恐惧:1.眉毛抬起并皱起;2.上眼睑抬起,下眼睑拉紧;

沮丧:1.眉毛内角周期并向上抬;2.眼内角上眼皮抬高;

眼部ROI比例因子:

嘴部表情特征识别:根据嘴部ROI比例因子进行识别判断,分别为包括有X

开心:嘴巴可能张开并露出牙齿,唇角向后拉并上抬;

恐惧:嘴巴张开,嘴唇向后拉;

沮丧:嘴角下拉;

嘴部ROI比例因子:

建立除了输入层,网络深度为15层的神经网络,其中包括6层卷积层、3层池化层,2层shortcut层,1层可分离卷积层,2层全连接层和1层分类层。为了增强不同表情类间的差异性,同时最小化相同类内的距离,网络模型采用softmax loss与center loss联合的损失函数,最后采用多数投票集成法来获得最后的判别结果。

机器人本体通过表情识别算法获取识表情别结果,并匹配对应的识别情绪类型,将使用者识别情绪类型与接收到的初步判断情绪类型进行比对,当对比属于同一类型情绪时,机器人本体进行对应动作以对使用者进行治愈。当情绪类型不一致时,则再次进行初步判断情绪类型及识别情绪类型的获取分析。

若确认的情绪类型为高兴,机器人本体执行高兴子算法,像素眼显示开心表情,并摇动机械尾巴,通过语音识别模块与使用者进行交互对话;

若确认的情绪类型为恐惧,机器人本体执行恐惧子算法,跟随使用者并缩短跟随距离至0.5m,同时选取若干句设定中用于恐惧治愈的语音并发声,并于语音发声结束后播放对应存储用于放松的歌曲;

若确认的情绪类型为悲伤,机器人本体执行悲伤子算法,跟随使用者并缩短跟随距离至0.5m,同时选取若干句设定中用于悲伤治愈的语音并发声,并于语音发声结束后播放对应存储用于舒缓的歌曲,并在歌曲结束后播放选取的若干段笑话;

每间隔0.5s通过检测使用者实时特征指标,进行判断,若判定情绪保持,机器人本体维持治愈动作;若使用者情绪恢复至平静状态,则终止表情识别算法并停止当前治愈动作。

同时,机器人本体通过语音识别模块实时接收使用者语音指令信息,当接收到使用者拒绝治愈或拒绝接近指令时,机器人本体停止运动,同时停止表情识别及治愈动作,恢复至初始状态。

具体的,机器人本体接收到情绪检测请求信号时:

当机器人本体处于跟随使用者状态时,可通过发声吸引使用者转向朝向机器人本体以抓取拍摄使用者面部图片,也可通过机器人本体通过人像识别算法结合运动模块,移动至使用者面部前方,拍摄使用者面部图片,再对面部图片进行表情识别算法。

当机器人本体处于待机状态时,机器人本体通过手环定位确定使用者方位并移动靠近,红外热释传感器实时检测周围环境,云台带动机器人本体旋转搜索使用者,摄像头实时拍摄,通过人形轮廓分析提取算法进行人像识别确认使用者,直至处于跟随或靠近使用者状态,再进行面部图片抓取及表情识别。

机器人本体在进行情绪治愈时寻找跟随使用者,在待机状态下也进行检测,以在检测到使用者时跟随并陪伴使用者。面对独居人群,机器人本体通过智能跟随进行陪伴。具体操作如下:

语音识别模块实时检测使用者语音指令,并在接收到使用者召唤语音指令时,启动红外热释传感器进行检测判断使用者是否在周围设定范围内;红外热释传感器安装有四个,分别安装在机器人本体的四周,能对机器人本体四周环境实时或周期性进行检测。

待机状态下红外热释传感器周期性检测周围环境,优选设置为每间隔10秒检测一次周围环境,且检测范围为2-3米范围内。待机状态时,摄像头关闭。

当红外热释传感器启动并检测到设定检测范围内存在使用者时,启动摄像头模块,并通过PID算法控制云台带动摄像头旋转以寻找并确定使用者方位;云台设置于机器人本体的脖子处,可周向旋转360度,通过PID算法控制云台并带动机器人本体旋转360度以进行人像识别搜索。

PID控制算法为:在PID算法中要明确设定值与实际值,然后计算出偏差err=设定值-实际值。通过偏差得到补偿量,即实际值加上补偿量就会接近设定值。补偿量的计算方法有很多,一般有位置式,增量式。这里采用位置式的计算方法

PID_return=kP*errP+kI*errI+kD*errD

其中errP=err,errI+=err,errD=err-err_last。err_last为上一次的误差。

由于errI是误差的累加,为了防止溢出一般来讲是需要限幅。限幅采用的方法是超限削弱积分法。限制积分的上限为某一恒定值,当误差累加超过上限值时使得err

通过人像识别法识别使用者,并通过避障算法向使用者方向前行,直至移动到预定位置后进行设定距离的跟随。

其中,机器人本体的前端的左右两侧设置有激光测量传感器,实现实时测距及智能避障。摄像头模块执行人像识别算法后找到使用者的方向,宠物机器人转向摄像头所指的方向并前行。当前方激光测量传感器与摄像头模块检测到前方存在非人障碍物时,比较左右激光测量传感器所测量的数据,通过PID方法,若左侧激光测量传感器返回值较大,则宠物左转,若右侧激光测量传感器返回值较大,则宠物右转。待绕过非人障碍物后,继续执行人像识别算法跟踪使用者的位置与方向,直到移动到距使用者1-1.5m的预定位置。

当机器人本体接收到使用者发出的拒绝跟随语音指令时,停止跟随并退后超出检测范围并进入待机状态。

其中,人像识别算法通过人形轮廓分析提取算法进行人像识别,基于CNN(卷积神经网络)网络库进行人像识别,既可以检测人的背影也可以识别人脸以及人的侧影。保证了摄影头稳定的跟踪使用者,防止丢失使用者的位置信息。

人像识别采用改进的高斯混合背景模型(Gaussian Mixture Model,GMM)的人型轮廓分析提取算法。可以实现在多种典型的家居场景下准确有效地寻找到人像。

高斯模型的理论基础是高斯分布。其公式如下

其中,x为随机变量,μ为均值,σ为方差。对于每帧图像,每个像素点的像素值在一段时间内的分布服从高斯分布。然而在实际家居生活中,存在各种各样的噪声干扰,例如光线变化和风扇的旋转等,一个高斯分布无法准确的描述背景信息。高斯混合背景模型使用多个高斯分布对动态变化的背景进行建模,用多个模型来描述背景信息,以达到更加准确提取背景的效果。在高斯混合模型中,假设每个像素点之间相互独立。背景图像的每一个像素分别用K个高斯分布构成的高斯混合模型来建模,即

其中,x

进行背景的训练与前景提取:

使用前几帧图像进行背景训练,建立高斯模型,同时背景发生改变时对背景进行实时更新。得到背景信息后即可进行前景提取。将背景训练得到的高斯模型按照

其中,T为阈值,1≤b≤K。

将采集到的图像的每个像素点的灰度值与B个高斯模型进行比较,若满足

则该像素属于背景,否则属于前景。

在家居环境下,除了行人,还存在很多运动目标,例如,猫、狗和滚动的皮球等等,这些运动目标都会被高斯混合模型提取出来,需对前景信息进行区分,采用基于宽度直方图的轮廓判别法。将前景信息区域的像素按照竖直方向建立宽度直方图。对于人形轮廓其宽度变化趋势见图3所示。曲线的第一个峰值区域对于人的头部,由于脖颈的宽度小于头部的宽度,曲线下降,接着去先开始快速上升,达到第二个峰值,这对于着肩部的宽度,并且大于头部的宽度,然后去先开始下降速度由快变慢,再变快。

按照如下步骤进行人型轮廓判别,如图4所示。

(1)绘制轮廓宽度直方图;

(2)计算宽度直方图的驻点,若驻点小于4,则判定为非人形轮廓;否则,选取对应人的头部轮廓,颈部轮廓,肩部轮廓和腿部轮廓的驻点,分别记为y

(3)比较四个驻点的大小。若y

(4)计算头部宽度于肩部宽度的比值

最后,将得到的前景信息取平均值,计算出平均的横坐标,作为Openmv的当前目标位置(记为px)。至此完成对于人像识别。

摄像头模块执行人像识别算法后找到使用者的方向,宠物机器人转向摄像头所指的方向并前行。如图5所示,当前方激光测量传感器与摄像头模块检测到前方存在非人障碍物时,比较左右激光测量传感器所测量的数据,通过PID方法,若左侧激光测量传感器返回值较大,则宠物左转,若右侧激光测量传感器返回值较大,则宠物右转。待绕过非人障碍物后,继续执行人像识别算法跟踪使用者的位置与方向,直到移动到距使用者1-1.5m的预定位置。

其中,PID控制算法为:在PID算法中要明确设定值与实际值,然后计算出偏差err=设定值-实际值。通过偏差得到补偿量,即实际值加上补偿量就会接近设定值。补偿量的计算方法有很多,一般有位置式,增量式。这里采用位置式的计算方法

PID_return=k

其中err

由于err

手环及机器人本体相互配合进行二次检测,先通过手环实时进行检测采集初步判断使用者情绪类型,并在判断出现非平静状态情绪时通过机器人本体进行面部表情识别,进而进行二次判断,以使得对使用者情绪的识别把握更加准确,机器人本体对应使用者情绪作出相对应动作,可实时掌握使用者的情绪状态来变换不同的陪绑模式,能给使用者带来一定程度的治愈效果。

本具体实施例仅仅是对本发明的解释,其并不是对本发明的限制,本领域技术人员在阅读完本说明书后可以根据需要对本实施例做出没有创造性贡献的修改,但只要在本发明的权利要求范围内都受到专利法的保护。

- 一种面向独居人群的机器人智能情绪识别治愈方法

- 一种面向体弱人群的沐浴辅助智能机器人