一种基于级联全卷积神经网络的机器人快速抓取方法

文献发布时间:2023-06-19 12:24:27

技术领域

本发明涉及计算机视觉,深度学习领域,具体涉及一种基于级联全卷积神经网络的机器人快速抓取方法。

背景技术

作为机器人在工厂、家居等环境中最常用的基础动作,机器人自主抓取有着广泛的应用前景,近十年来研究人员对其给予了较高的关注,然而,在非结构环境下任意物体任意姿态的准确抓取仍然是一项具有挑战性和复杂性的研究。但是由于机器人在感知和控制方面仍有很大的局限性,机器人抓取在多个关键技术上面临着诸多挑战,定位和识别是机器人抓取中的主要难题。在复杂场景下识别到目标的物体,并施以有效的抓取控制策略,是机器人抓取面临的最大难题。早期的机器人抓取是仅从2D部分视图数据中通过简单的形态学处理得到物体的质心,以质心的位置传给末端执行器,由于只有二维信息,第三维度的距离必须是固定的抓取具有局限性。3D数据的使用改善了这些问题,随着Kinect,Realsense等深度相机的出现,深度信息在机器人中使用变得更加普遍。

随着人工智能的发展,越来越多的人把深度学习应用到各个领域,目前使用学习的方法抓取检测有两种:一是基于抓取检测的抓取方法,通过抓取检测方法生成抓取位姿,再使用单独的规划控制系统生成轨迹先完整的抓取;二是基于视觉运动控制策略的端到端抓取方法,实现图像直接到抓取动作的映射。第1类方法如目前主要痛点在于检测速度不够快不能够实现实时抓取。第2类如王斌等提出的端到端的算法研究(王斌.基于深度图像和深度学习的机器人抓取检测算法研究[D].杭州:浙江大学机械工程学院,2019:1-85)常常达不到理想的效果,并且没有开源的数据集,一般的实验室难以实现。

因此,需要寻找一种抓取检测准确率高同时速度快的机器人抓取的方法。

发明内容

为了解决现有技术所存在的技术问题,本发明提供一种基于级联全卷积神经网络的机器人快速抓取方法,通过建立一种参数少的两阶段的全卷积神经网络,利用数据增强后的开源数据集Cornell数据集训练,同时利用几何关系画出最佳抓取的抓取策略,两阶段的网络解决了数据容易过拟合的问题,参数少保证了推测的快速性。

本发明至少通过如下技术方案之一实现。

一种基于级联全卷积神经网络的机器人快速抓取方法,包括以下步骤:

S1、基于编码-解码的网络结构建立机器人最佳抓取位置和角度的全卷积神经网络模型;

S2、使用数据集对所述全卷积神经网络模型进行训练和测试;

S3、对摄像头内参进行标定;

S4、利用训练好的全卷积神经网络模型对标定后的摄像头获得的深度信息获取抓取位置和角度;

S5、根据最佳的抓取策略,进行机器人抓取。

优选的,所述全卷积神经网络模型包括两个阶段,第一阶段和第二阶段均包括编码器模块和解码器模块,其中第一阶段和第二阶段均产生一个损失,损失定义为预测的抓取角度、抓取宽度和抓取质量和实际的真实间的均方误差;所述编码器模块包括卷积层,所述解码器模块包括反卷积层。

优选的,所述卷积层数量和参数均与反卷积层的相同。

优选的,全卷积神经网络模型的输出是三幅与其输入是相同的尺寸的图像,分别包括每个像素点的抓取角度信息、抓取宽度信息和抓取质量信息。

优选的,在步骤S2中,先对数据集进行数据集增强操作,包括随机截取、随机缩放、随机翻转,将增强后的数据集为训练集和测试集;在随机翻转的操作中,翻转范围为

优选的,训练全卷积神经网络模型时,采用均方误差损失函数作为训练性能的指标;模型测试时,对于预测的抓取框是否正确采用IOU评价指标:

其中,A为预测矩形,B为真实矩形,IOU预测矩形和真实矩形之间面积的交并比为评价指标。

优选的,在步骤S4中,用训练好的模型进行抓取预测后,根据最佳的抓取位置,角度,宽度进行物体最佳抓取框的显示,具体包括以下步骤:

S41、将固定于机械臂上的深度相机获取到的深度图像信息均输入到全卷积神经网络模型的两个阶段中,预测输出得到三幅图像,分别对应着每个像素点的抓取质量、夹爪旋转角度、夹爪张开宽度;

S42、确定抓取位姿之后,将输出的抓取位姿标注到输入的深度图像上,然后再将深度图变换成物体的彩色图;

假设原本的抓取框为ABCD,经过旋转后抓取框为A1B1C1D1,假设抓取成功概率最高的是O点,其坐标是(x

x

y

旋转后点A1的坐标为:

点B1、点C1、点D1的坐标采用类似的方法。

优选的,标定数据包括焦距、光心位置和畸变系数。

优选的,所述数据集采用增强后的Conell数据集。

优选的,所述训练是在NVIDIA服务器上进行的;由于网络结构的关系,所有输入的深度图片resize成HxH大小,最终得到的输出同样为H×H×3。

本发明与现有技术相比,具有如下优点和有益效果:

本发明通过设计一种参数少的两阶段的全卷积神经网络,利用数据增强后的开源数据集Cornell数据集训练,同时利用几何关系画出最佳抓取的抓取策略,两阶段的网络解决了数据容易过拟合的问题,参数少保证了推测的快速性。

附图说明

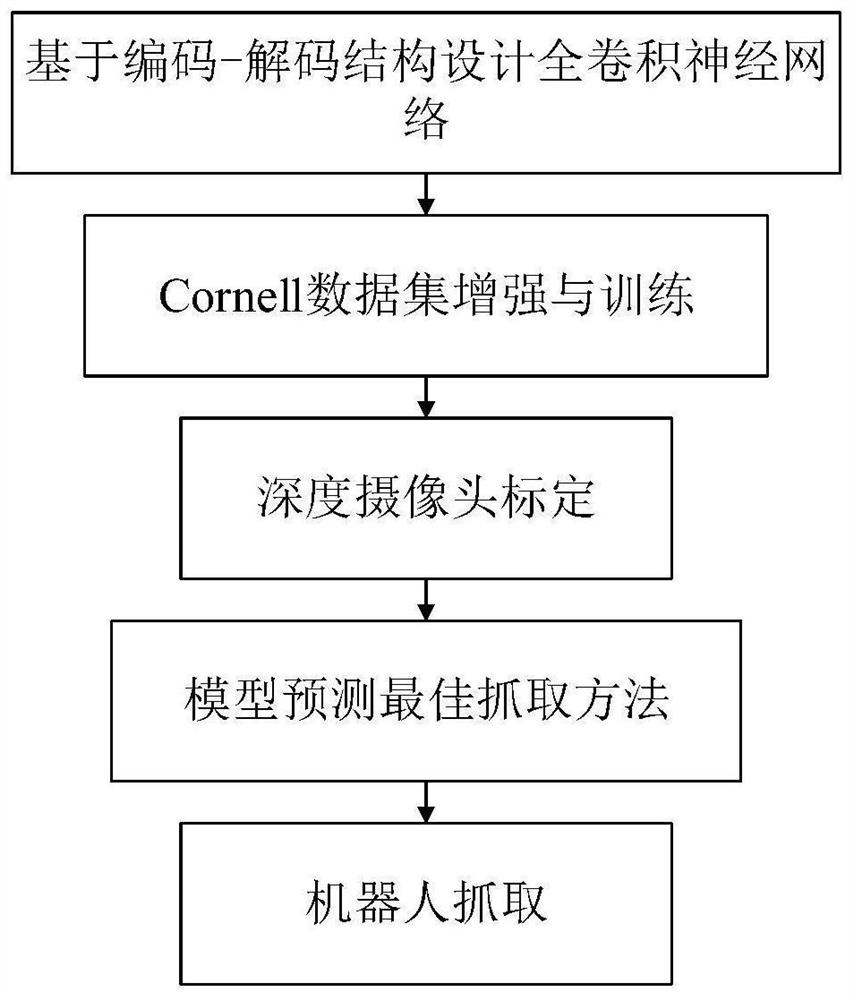

图1为本发明实施例方法的流程图;

图2为本发明实施例搭建的两阶段卷积神经网络的结构图;

图3为本发明实施例基于深度相机的机器人抓取整体结构图;

图4为本发明实施例机器人训练后的最佳抓取框显示图;

图5为本发明实施例训练过程中的训练损失随着训练步数增大的变化图;

图6为本发明实施例训练过程中的准确率随着训练步数增大的变化图。

具体实施方式

本部分将详细描述本发明的具体实施例,本发明之较佳实施例在附图中示出,附图的作用在于用图形补充说明书文字部分的描述,使人能够直观地、形象地理解本发明的每个技术特征和整体技术方案,但其不能理解为对本发明保护范围的限制。

如图1所示,本发明基于级联全卷积神经网络的机器人快速抓取方法,包括以下步骤:

S1、基于编码-解码的网络结构建立机器人最佳抓取位置和角度的全卷积神经网络模型,该网络模型具有轻量化的特点;

S2、使用Conell数据集对所述全卷积神经网络模型进行训练和测试。Conell数据集经过数据集增强包括随机截取、随机切片、随机旋转,将增强后的数据集按照4:1分为训练集和测试集,训练集输入到步骤S1的全卷积神经网络模型中训练,并对模型进行测试,取在测试集上精度最高的模型为最终模型;

S3、对深度摄像头进行标定;摄像头内参标定包括焦距、光心位置和畸变系数;

S4、对标定后摄像头获得的深度图片输入到训练好的全卷积神经网络中,可以得到和输入的深度图片大小相同的抓取质量、抓取角度和抓取宽度三张图片,先从输出的抓取质量图中找到抓取质量最高的像素点,再通过抓取角度图和抓取宽度图中找到此像素点对应的最佳抓取角度和最佳抓取宽度,进而完成抓取框的标注。

S5、根据最佳的抓取策略,控制机械臂的夹爪张开网络输出的宽度,机械臂末端的关节输出网络输出的旋转的角度,通过最佳抓取点的深度控制机械臂运动到相应的位置。

如图2所示,在步骤S1中卷积神经网络,采用编码器-解码器的结构,主要包括自上而下的路径作为编码器和自下而上的解码器,利用经典的全卷积神经网络思想,使用反卷积层代替全连接层,实现更高的计算效率。另一方面,池化层的下采样过程中会造成图片的分辨率降低的后果,而利用反卷积层就可以恢复到原本的分辨率。但是如果采用卷积层和反卷积层不对等的架构,虽然可以在一定程度上恢复图片的分辨率,但是却无法保证原本图片内特征的位置信息不发生改变。因此,为了保证在恢复图片分辨率的同时,还保留原本图片特征的位置信息,采用基于全卷积神经网络的对称编码-解码网络结构,卷积层数量和参数均与反卷积层的一致,最大限度的保证提取图片特征后保持特征的位置不变,完成更好的分割效果。

建立的卷积神经网络分为两个阶段,共12层。该网络每个阶段都为一个6层网络,前三层为卷积层,构成编码器模块,后三层为反卷积层,构成解码器模块,其中算法网络参数如下表,第一阶段输出的图像以及初始输入第一阶段的图像均输入到第二阶段,即增加了一个保留原始信息的阶段,通过该阶段可以使用变换后的信息和初始信息。结合两幅图像可以获得更高的精度。

在步骤S2中模型的训练和测试包括以下步骤:

S21、增广数据集,Cornell数据集包含280个日常生活中常见的物体,每个物体包含4到7张图片,一共包含1035张图片。数据集增强是在给网络输入数据训练的同时进行的,并且采用随机翻转、随机截取和随机缩放的方式,避免了人为改变的重复操作。在随机翻转等操作的同时,可以设置翻转的角度范围,例如可以设置翻转的角度范围是

S22、将增强后的数据集的80%作为训练集,并用剩下的20%作为测试训练集。模型训练时,采用均方误差损失函数作为训练性能的指标。模型预测时,对于预测的抓取框是否正确采用IOU评价指标,如果IOU大于25%则认为抓取成功,否则为错误抓取。假设预测矩形为A,真实矩形为B,则两者之间的IOU为:

训练是在NVIDIA服务器上进行的。服务器显卡组由4块1080ti组成,共11G显存。服务器版本是UBUNTU16.04,编程语言版本是Python3.6。由于网络结构的关系,所有输入的深度图片resize成300x300大小,最终得到的输出同样为300×300×3。如附图4所示,一共训练了60个Epoch,其中在第32个Epoch,测试集的准确率达到0.89,经过训练,获得了一个轻量级模型,在TX2上运行时只有0.5MB,可以达到30FPS,保证了实时性。

在步骤S4中获得最佳抓取策略包括以下步骤:

S41、如图3所示,深度相机固定于机械臂上获取到的深度图像,如图3所,输入到所涉及的两阶段卷积神经网络中,预测输出得到三幅图像,分别对应着每个像素点的抓取质量、夹爪旋转角度、夹爪张开宽度。

S42、确定了抓取位姿之后,可以将输出的抓取位姿标注到输入的深度图像上,然后再将深度图变换成物体的彩色图,就可以还原在真实环境下显示物体的最佳抓取位姿。

原本的抓取框为ABCD,经过旋转后抓取框为A1B1C1D1。假设抓取成功概率最高的是O点,其坐标是(x

x

y

旋转后点A1的坐标为:

点B1、点C1、点D1的坐标可类似的方法获得。获得最佳的抓取框可以在实际抓取之前,直观的观察抓取是否合适,从而降低由于噪声或者其他因素造成的抓取失败导致硬件损坏。

如图4所示在真实的环境中测试上述方法是有效的,图5、图6为训练过程中的训练损失随着训练步数增大的变化图和训练过程中的准确率随着训练步数增大的变化图。

本发明通过建立参数少的两阶段的全卷积神经网络,利用数据增强后的开源数据集Cornell数据集训练,同时利用几何关系画出最佳抓取的抓取策略,两阶段的网络解决了数据容易过拟合的问题,参数少保证了推测的快速性。

上述实施例为本发明较佳的实施方式,但本发明的实施方式并不受上述实施例的限制,其他的任何未背离本发明的精神实质与原理下所作的改变、修饰、替代、组合、简化,均应为等效的置换方式,都包含在本发明的保护范围之内。

- 一种基于级联全卷积神经网络的机器人快速抓取方法

- 一种基于级联卷积神经网络的机器人非规则物体抓取位姿快速检测方法