一种基于关联度量的车流量统计方法

文献发布时间:2023-06-19 12:13:22

技术领域

本发明涉及智能交通技术领域,尤其涉及一种基于关联度量的车流量统计方法。

背景技术

当前,高速公路已经进入数字信息化建设时代,基于云-边的高速道路大型化信息综合管理平台,利用多模态传感器技术,通过对高速道路全方位、全时段的监控、监测,实现对高速路网综合监控管理运营。其中,视频监控设备由于布设简单、成本低,被广泛的安装在道路路侧,而传统的线圈检测器由于布设困难,安装率逐渐降低,激光雷达等设备由于价格昂贵普及率仍然较低。因此,对大规模监控视频进行数据分析,实时监测路网车流量、车速等信息,及时发现道路拥堵指数、饱和度等的异常变化,并将异常信息上报至监控平台,已成为路网管理和交通精准管控的重要手段。

目前基于路侧监控视频的交通流量统计方法,由于不能很好的跟踪车辆行为,造成漏检、误检率较高,且缺乏一个有效的车辆关联关系度量方法,造成场景迁移困难,无法对多个不同路段场景提供准确的统计结果,难以应用于精准的交通监测。因此,本发明引入深度学习方法,提出一种高效准确的基于关联度量的车流量统计方法,通过持续跟踪经过虚拟断面的车辆行为,减少由于车辆换道、互相遮挡带来的漏检、误检问题,为精准交通监测提供可靠依据。

发明内容

本发明的目的在于针对现有技术的不足,提供一种基于关联度量的车流量统计方法,解决现有的车流量统计方法由于不能准确持续跟踪车辆行为,造成的对通过虚拟断面车辆的漏检、误检而造成的车流量统计精准度缺失的问题。本发明方法引入基于深度学习的车辆检测方法,在连续视频帧中对运动车辆外框进行准确贴合的检测,通过融合前后视频帧中运动车辆的位置重叠度和特征匹配度这两个度量因子,分析车辆的关联关系,从而达到对经过虚拟断面车辆的持续稳定跟踪,减少由于车辆换道、互相遮挡造成的统计结果不准的问题。

本发明的目的是通过以下技术方案来实现的:一种基于关联度量的车流量统计方法,该方法包括以下步骤:

步骤一:根据高速道路路侧监控视频,在视频画面中的单向车道区域无视觉遮挡部分设置一条水平虚拟断面线;

步骤二:定义虚拟断面线在视频画面中的高度为H;定义一个已统计车辆列表 L,存储已经过虚拟断面线的车辆信息,初始化为空;定义一个变量C = {car_id,bbox,Embedding_set,frame_id},表示一辆车的信息,其中car_id 表示车辆id,编号唯一;bbox表示车辆检测框位置,包含检测框的左上角坐标,检测框的右下角坐标;Embedding_set表示车辆检测框区域内所有子区域的特征向量的集合,一个车辆检测框区域根据车辆检测框的长宽比划分为多个子区域,每个子区域被ResNet50网络编码为特征向量;frame_id表示当前视频帧序列号,初始化为0,每过一帧,frame_id加1;定义车流量统计数目N,初始化为0;

步骤三:采用基于深度学习的目标检测方法检测出当前视频帧中的车辆,并过滤出车辆外边框和虚拟断面线交叉的车辆为待关联车辆,并对这些待关联车辆的检测框划分成多个子区域,并对每个子区域利用神经网络进行Embedding特征编码,将每个子区域编码为一个二进制的特征向量;

步骤四:分别计算待关联车辆和已统计车辆列表中车辆的特征匹配度和位置重叠 度;特征匹配度计算方法具体为:对任意一辆待关联车辆

对集合P中所有的子区域匹配完毕后,统计正确匹配的组数,并计算车辆

特征匹配度(

按此方法,计算出每一辆待关联车辆和已统计车辆列表中车辆间的特征匹配度;

步骤五:融合位置重叠度和特征匹配度这两个度量因子,对每一辆待关联车辆,计算其和已统计车辆列表中的车辆的关联度;关联度计算公式为:

关联度= 位置重叠度*λ + 特征匹配度*(1-λ)

其中λ为这两个度量因子的融合超参数,按实际具体的视频数据设定;

步骤六:步骤五中计算得到的关联度的最大值大于等于阈值的待关联车辆,说明其和已统计车辆列表中的车辆关联上了,该车已被统计,更新其在已统计车辆列表中的信息;对关联度的最大值小于阈值的,新建变量C,生成其车辆信息,并将其添加至已统计车辆列表,车流量统计数目N加1;

步骤七:将已统计车辆列表中视频序列号和当前视频帧序列号差值大于M的车辆删除,认为M帧前的车辆已驶离虚拟断面线;其中M值和当前监控视频中车辆大小相关,通过观测车辆从到达虚拟断面线至驶离虚拟断面线所经历的最长视频帧数得到;

步骤八:重复步骤三~步骤七,直至待车流量统计视频结束。

进一步地,根据车辆检测框的长宽比划分为多个子区域具体过程为:按照车辆检测框的长宽比,将检测框区域划分为M=A*B个子区域,A表示垂直划分等份数,B表示水平划分等份数;其中,A,B表示如下:

其中,

进一步地,所述步骤三通过以下子步骤来实现:

(3.1)将当前帧图像输入目标检测模型,检测出当前视频帧图像中的车辆;其中,目标检测模型基于CenterNet网络模型,通过采用高速道路车辆的标注数据进行训练,能准确稳定的检测出贴合车辆的矩形外边框;

(3.2)计算检测出的车辆的矩形外边框是否和虚拟断面线相交;假设一辆车的检 测框位置的左上角坐标为

(3.3)将待关联车辆根据车辆检测框的长宽比划分为多个子区域,每个子区域分 别输入ResNet50网络,所述ResNet50网络通过数据集ImageNet训练完成,且将最后一层特 征层维度修改为K,则最后一层特征层即为该子区域的特征向量,将该特征向量中数值大于 等于

进一步地,所述步骤四中,位置重叠度计算方法具体为;假设某一待关联车辆检测 框的左上角坐标为

按此方法,计算出每一辆待关联车辆和已统计车辆列表中车辆间的位置重叠度。

进一步地,所述步骤六通过以下子步骤来实现:

(6.1)对某一辆待关联车辆,最大关联度值大于等于阈值

(6.2)对某一辆待关联车辆,最大关联度值小于阈值的则认为未关联上,该车第一次被检测到通过虚拟断面线,车流量统计数目N加1,新建变量C为该车的车辆信息,并将该车辆信息C添加至已统计车辆列表。

本发明的有益效果是,本发明提出一种高效准确的基于关联度量的车流量统计方法,采用深度学习的目标检测方法对运动车辆进行检测,通过对连续视频帧中的运动车辆进行关联度分析,实现对经过虚拟断面车辆的持续稳定跟踪,显著减少由于车辆换道、互相遮挡造成的车流量统计结果不准的问题。其实现方法简单高效,能有效的运用于广泛布设的视频摄像头的高速道路的交通监控,为交通管理精准决策提供可靠支撑。

附图说明

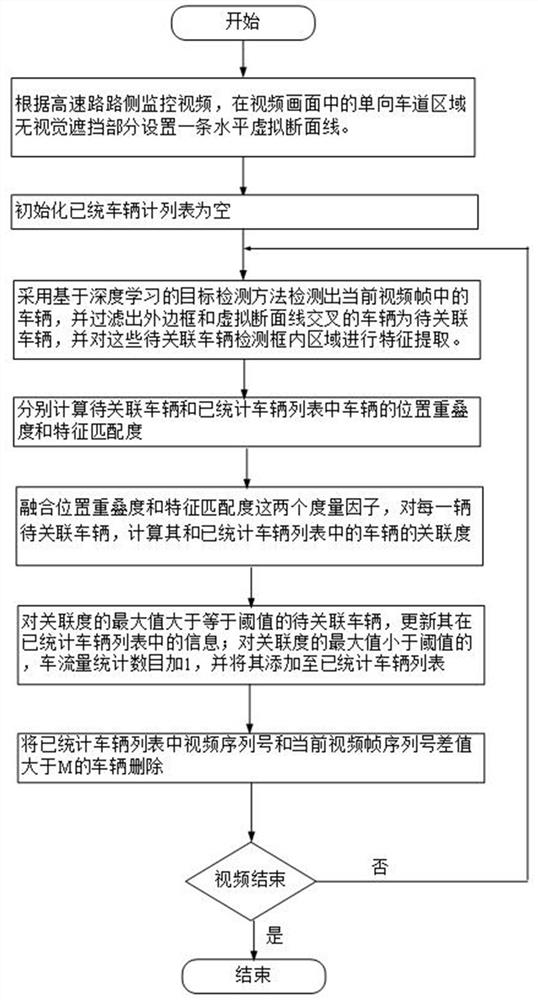

图1是本发明基于关联度量的车流量统计方法流程图。

图2是在高速道路杭向、甬向车道区域分别放置一条水平虚拟断面线示意图。

图3是基于目标检测模型检测出视频帧中的车辆,并过滤出外边框和虚拟断面线交叉的车辆示意图。

图4是杭向车道区域车辆car_39第一次被检测到通过杭向车道虚拟断面线示意图。

图5是杭向车道区域车辆car_39被持续跟踪经过杭向车道虚拟断面线示意图。

图6是高速道路杭向、甬向车道最近5分钟的车流量统计结果示意图。

具体实施方式

下面根据附图详细说明本发明,本发明的目的和效果将变得更加明白。应当理解,此处所描述的具体实施例仅用以解释本发明,并不用于限定本发明。

如图1所示,本发明提出了一种基于关联度量的车流量统计方法,包括以下步骤:

步骤一:根据沪杭甬高速道路路侧监控视频,在视频画面中的杭向车道区域无视觉遮挡部分设置一条水平虚拟断面线。虚拟线设置如图2所示。

步骤二:定义虚拟断面线在视频画面中的高度为H;定义一个已统计车辆列表 L,存储已经过虚拟断面线的车辆信息,初始化为空;定义一个变量C = {car_id,bbox,Embedding_set,frame_id},表示一辆车的信息,其中car_id 表示车辆id,编号唯一;bbox表示车辆检测框位置,包含检测框的左上角坐标,检测框的右下角坐标;Embedding_set表示车辆检测框区域内所有子区域的特征向量的集合,一个车辆检测框区域根据车辆检测框的长宽比划分为多个子区域,每个子区域被ResNet50网络编码为特征向量;frame_id表示当前视频帧序列号,初始化为0,每过一帧,frame_id加1;定义车流量统计数目N,初始化为0。

步骤三:采用基于深度学习的目标检测方法检测出当前视频帧中的车辆,并过滤出车辆外边框和虚拟断面线交叉的车辆为待关联车辆,如图3所示。并对这些待关联车辆的检测框划分成多个子区域,并对每个子区域利用神经网络进行Embedding特征编码,将每个子区域编码为一个二进制的特征向量;

该步骤是本发明的核心,分为以下子步骤。

(3.1)将当前帧图像输入目标检测模型,检测出当前视频帧图像中的车辆。其中,目标检测模型基于CenterNet网络模型,通过采用高速道路车辆的标注数据进行训练,能准确稳定的检测出贴合车辆的矩形外边框。

(3.2)计算检测出的车辆的边框是否和虚拟断面线相交。假设一辆车的检测框位 置的左上角坐标为

(3.3)将待关联车辆按照车辆检测框的长宽比,将检测框区域划分为M=A*B个子区域,A表示垂直划分等份数,B表示水平划分等份数。其中,A,B表示如下:

其中,

(3.4)将每个子区域分别输入ResNet50网络,该网络已用大型数据集ImageNet训 练好了,且最后一层特征层维度已修改为256。该网络具备提取图像的浅层和深层特征的能 力,该网络的最后一层特征层即为该子区域的特征向量,将该特征向量中数值大于等于0.0 的编码为1,小于0.0的编码为0,转换为二进制向量。则一辆待关联车辆的检测框区域特征 编码描述为

步骤四:分别计算待关联车辆和已统计列表中车辆的位置重叠度和特征匹配度。

该步骤是本发明的核心,分为以下子步骤。

(4.1)分别计算待关联车辆和已统计车辆列表中车辆的检测框的位置重叠度。假 设某一待关联车辆检测框的左上角坐标为

按此方法,计算出每一辆待关联车辆和已统计车辆列表中车辆间的位置重叠度。

(4.2)分别计算待关联车辆和历史车辆列表中车辆的特征匹配度。

对任意一辆待关联车辆

对集合P中所有的子区域匹配完毕后,统计正确匹配的组数,并计算车辆

特征匹配度(

按此方法,计算出每一辆待关联车辆和已统计车辆列表中车辆间的特征匹配度。

步骤五:融合位置重叠度和特征匹配度这两个度量因子,对每一辆待关联车辆,计算其和已统计列表中的车辆的关联度。关联度计算公式为:

关联度= 位置重叠度*λ + 特征匹配度*(1-λ)

其中λ按实际视频数据设定为0.6。在沪杭甬高速道路监控视频中车辆前后帧运动确定性较高,通过车辆位置重叠度能有效关联前后帧的车辆,且融合特征匹配度能很好的减少车辆变道或相互遮挡带来的目标丢失问题,有效关联前后帧的车辆。

步骤六:对关联度的最大值大于等于阈值的待关联车辆,更新其在已统计车辆列表中的信息;对关联度的最大值小于阈值的,车流量统计数目加1,并将其添加至已统计车辆列表。

该步骤是本发明的核心,分为以下子步骤。

(6.1)对某一辆待关联车辆,最大关联度值大于等于阈值

(6.2)对关联度小于阈值的则认为未关联上,该车第一次被检测到通过该虚拟断面线,车流量统计数目N加1,新建变量C为该车的车辆信息,并将该车辆信息C添加至已统计车辆列表。

杭向车道区域车辆car_39被持续跟踪效果如图4和图5所示。图4是杭向车道区域车辆car_39第一次被检测到通过杭向虚拟断面线。图5是杭向车道区域车辆car_39最后一次被检测通过杭向虚拟断面线。

步骤七:将已统计车辆列表中视频序列号和当前视频帧序列号差值大于M的车辆删除,其目的在于减少关联搜索空间,认为M帧前的车辆已驶离虚拟断面线;其中M值和当前监控视频中车辆大小相关,通过观测车辆从到达虚拟断面线至驶离虚拟断面线所经历的最长视频帧数得到;M可设置为10。

步骤八:重复步骤三~步骤七,直至待统计车流量视频结束。

杭向车道区域车辆最近5分钟车流量统计结果如图6所示。

上述实施例用来解释说明本发明,而不是对本发明进行限制,在本发明的精神和权利要求的保护范围内,对本发明作出的任何修改和改变,都落入本发明的保护范围。

- 一种基于关联度量的车流量统计方法

- 一种基于无人机交通视频的车流量统计方法