虚拟现实头戴送受话器中的动态会聚调整

文献发布时间:2023-06-19 12:02:28

相关申请的交叉引用

本申请要求2018年12月10日提交的题为“DYNAMIC CONVERGENCE ADJUSTMENT INAUGMENTED REALITY HEADSETS”的美国临时申请No. 62/777,545的权益,所述申请出于所有目的以其整体通过引用并入本文中。

背景技术

本公开总体上涉及在模拟环境内发生的增强现实、虚拟现实、混合现实或任何其他合适的交互式计算机生成的体验。更具体地,本公开的某些实施例涉及提供交互式计算机生成的体验的头戴送受话器(headset)的操作特征。

作为示例,增强现实系统越来越受欢迎。现在认识到的是,用于提供增强现实系统(诸如增强现实头戴送受话器)的常规技术将受益于对系统部件和功能性的改进。特别地,现在认识到的是,用于提供增强现实视觉效果的某些传统系统和技术能够引起感官冲突。因此,存在提供被配置成限制或防止这样的传感器冲突的改进的增强现实系统的需要。

本部分旨在向读者介绍可能与本技术的各个方面相关的领域的各个方面,其在下面描述和/或要求保护。相信该讨论有助于向读者提供背景信息,以促进对本公开的各个方面的更好的理解。因此,应当理解的是,要就此而论而不是作为对现有技术的承认来阅读这些陈述。

发明内容

下面概述了与原始要求保护的主题在范围上相称的某些实施例。这些实施例不旨在限制本公开的范围,而是这些实施例仅旨在提供某些所公开的实施例的简要概述。实际上,本公开可以涵盖可以与以下阐述的实施例类似或不同的多种形式。

特别地,在一个实施例中,增强现实系统包括具有左显示器的增强现实头戴送受话器,所述左显示器向用户的左眼显示左虚拟图像。增强现实头戴送受话器还包括右显示器,所述右显示器向用户的右眼显示右虚拟图像。当用户观看左虚拟图像和右虚拟图像时,左虚拟图像和右虚拟图像对于用户而言作为单个虚拟图像出现。增强现实头戴送受话器还包括瞳孔跟踪传感器,其检测用户的瞳孔位置并提供用户的瞳孔位置的指示。增强现实系统还包括具有瞳孔间距离确定引擎的会聚调整系统,所述瞳孔间距离确定引擎基于接收瞳孔位置的指示来确定用户的瞳孔间距离。会聚调整系统还包括显示调整引擎,其基于瞳孔间距离和虚拟对象正在改变虚拟深度的指示来提供对虚拟图像的虚拟对象的显示的调整。会聚调整系统还包括基于来自显示调整引擎的调整来显示虚拟对象的处理器。

在另一个实施例中,一种有形的、非暂时性的、计算机可读介质,其具有用于调整虚拟对象的显示的指令,所述指令当由处理器执行时,使得处理器接收虚拟对象要被显示为从相应第一虚拟深度移动到相应第二虚拟深度的指示。所述指令还使得处理器确定瞳孔间距离,以及基于瞳孔间距离动态地确定与在相应第一虚拟深度处的每个虚拟对象相关联的相应第一注视线和与在相应第二虚拟深度处的虚拟对象相关联的相应第二注视线之间的相应横向距离。所述指令还使得处理器基于相应横向距离将每个虚拟对象显示为从相应第一虚拟深度移动到相应第二虚拟深度。

在又一个实施例中,一种用于调整虚拟对象的显示的方法包括接收一个或多个所显示对象要被显示为从第一虚拟深度移动到第二虚拟深度的指示。所述方法还包括确定瞳孔间距离,以及基于瞳孔间距离确定与在第一虚拟深度处的所显示对象相关联的第一会聚向量和与在第二虚拟深度处的所显示对象相关联的第二会聚向量之间的横向距离。所述方法还包括基于横向距离将所显示对象显示为从第一虚拟深度移动到第二虚拟深度。

附图说明

当参考附图阅读以下详细描述时,本公开的这些和其他特征、方面和优点将变得更好理解,其中,贯穿附图,相同的字符表示相同的部分,在所述附图中:

图1是根据本公开的实施例的用户佩戴增强现实头戴送受话器的透视图;

图2是根据本公开的实施例的从用户的视角的图1的增强现实头戴送受话器的透视图;

图3是根据本公开的实施例的并入图1的增强现实头戴送受话器的增强现实系统的框图;

图4是用户通过图1的增强现实头戴送受话器观看虚拟对象的示意性平面视图;

图5是根据本公开的实施例的通过增强现实头戴送受话器正在被观看的图4的虚拟对象的用户的视角的示意性表示;

图6是根据本公开的实施例的在图4的虚拟对象改变虚拟深度时的用户通过增强现实头戴送受话器观看图4的虚拟对象的示意性平面视图;

图7是根据本公开的实施例的在虚拟对象改变虚拟深度时的当通过增强现实头戴送受话器观看时图6的虚拟对象的用户的视角的示意性表示;以及

图8是根据本公开的实施例的用于调整虚拟对象的显示的过程的流程图。

具体实施方式

在现实世界中,当人观看其正前面的对象时,此人同时将他们的眼睛在朝向彼此的相反方向上移动,使得每只眼睛的注视会聚在该对象上或者每只眼睛的瞳孔与对象成一直线(被称为聚散的过程),并改变他们眼睛的光学功率(optical power)以维持对象的清晰图像或对象上的聚焦(被称为适应的过程)。因此,人习惯于将他们的注视指向同一固定点处,他们同时将他们的眼睛聚焦在该点处以维持清晰图像。如果人在对象移动得更靠近时观看对象,则每只眼睛的注视进一步会聚在一起,并且眼睛的光学功率改变以维持对象的清晰图像。如果人在对象移动地离开更远时观看对象,则每只眼睛的注视发散,并且眼睛的光学功率改变以维持对象的清晰图像。增强现实头戴送受话器通常使用模拟景深的显示器。特别地,可以将显示器分成用于右眼观看的右显示器和用于左眼观看的左显示器。假设显示器通常是矩形的,增强现实头戴送受话器可以通过在右显示器和左显示器中的每个上显示具有虚拟对象的虚拟图像(例如,具有右虚拟对象的右虚拟图像和具有左虚拟对象的左虚拟图像)而在用户正前面显示具有虚拟对象的虚拟图像,其中相应虚拟对象的相应参考点(例如,中心或近似中心)比起外侧边缘更靠近每个显示器的内侧边缘。此外,虚拟对象的相应参考点可以离开每个显示器的内侧边缘相等距离。这是因为,在观看现实世界对象时,每个人的眼睛的注视将会聚到该人正在观看的对象。

为了使虚拟对象看来似乎更靠近用户,增强现实头戴送受话器可以放大显示器上的虚拟对象,同时维持从虚拟对象的相应参考点到每个显示器的内侧边缘的相等距离。为了使虚拟对象看来似乎更远离用户,增强现实头戴送受话器可以缩小显示器上的虚拟对象,同时维持从虚拟对象的相应参考点到每个显示器的内侧边缘的相等距离。然而,现在认识到的是,由于虚拟对象的相应参考点在看来似乎移动地更靠近以及更远离用户时维持与每个显示器的内侧边缘的相等距离,因此用户的眼睛在其处会聚的点可能不是虚拟对象看来似乎所在的位置。也就是说,用户的眼睛在其处会聚的点可能在虚拟对象看来似乎所在的位置前面或后面。这可能在观看虚拟对象时引起模糊或双重图像效果,从而导致负面的用户体验。

同时,用户的焦点可能指向虚拟对象看来似乎所在的位置。因此,用户可以将他们的注视指向与他们聚焦他们的眼睛的位置不同的点以维持清晰图像。这可能创建聚散适应冲突,该冲突可能导致不适、疲劳、持续的头痛和/或恶心。

根据本实施例,虚拟现实头戴送受话器的显示器可以呈现/显示虚拟对象。这样的对象的参考点(例如,沿着对象的特定维度的几何中心点)可用于描述本实施例的操作特征。特别地,根据本实施例控制这样的参考点之间的距离和增强现实头戴送受话器的特征以改进用户体验。例如,当虚拟对象被呈现为从第一虚拟深度改变成第二虚拟深度时,代替维持从虚拟对象的中心到增强现实头戴送受话器的显示器的内侧边缘的距离,在相应虚拟对象被呈现为从第一虚拟深度改变成第二虚拟深度时,本实施例动态地和横向地将每个虚拟对象移位相应距离。可以基于沿着显示器的用户的眼睛与在第一虚拟深度处的相应虚拟对象的第一会聚向量和用户的眼睛与在第二虚拟深度处的相应虚拟对象的第二会聚向量之间的横向距离、并且可以基于瞳孔间距离来动态地确定相应距离。以此方式,可以调整虚拟对象的显示,使得用户的眼睛的注视可以会聚在虚拟对象看来似乎所在的位置。因此,用户可以将他们的注视指向与他们将他们的眼睛聚焦的位置相同的点,以维持清晰图像。因此,当前公开的系统和方法可以减少或消除当显示虚拟对象的虚拟深度的改变时的聚散适应冲突,从而减少或避免当观看虚拟对象时的可能的模糊或双重图像效果、不适、疲劳、持续的头痛和/或恶心,从而产生更好的用户体验。

虽然本公开讨论了增强现实和增强现实头戴送受话器的使用,但应当理解的是,所公开的技术还可以应用于虚拟现实、混合现实或在模拟环境内发生的任何其他合适的交互式计算机生成的体验。此外,关于虚拟对象的术语“深度”的使用应当被理解为指代虚拟对象的虚拟深度。也就是说,术语“深度”和“虚拟深度”指代基于通过增强现实头戴送受话器观看虚拟对象,虚拟对象(例如,从用户的视角)看来似乎被定位或设置在的深度。

考虑到这一点,图1是根据本公开的实施例的佩戴增强现实头戴送受话器12的用户10的透视图。增强现实头戴送受话器12可以提供与现实世界环境重叠或结合的模拟视觉环境。如所图示,增强现实头戴送受话器12可以包括前置摄像头14,其向用户10提供现实世界环境的显示。在附加或可替代实施例中,增强现实头戴送受话器12可以代替地包括透镜或透明显示器,其中用户10直接观看现实世界环境。也就是说,增强现实头戴送受话器12可以被提供给用户10而不经由显示器再现现实世界环境。

图2是根据本公开的实施例的从用户10的视角的增强现实头戴送受话器12的透视图。如所图示,增强现实头戴送受话器12包括显示器20,其可以被分成两个单独的显示器22、24。特别地,左显示器22可以被用户的左眼观看并且右显示器24可以被用户的右眼观看。在一些实施例中,左显示器22和右显示器24可以是两个不同的物理显示器,而不是单个显示器20的部分。显示器20可以包括不透明屏幕,其通过经由图1中所示的前置摄像头14接收的图像向用户10再现现实世界环境。例如,显示器20可以是智能电话或平板电脑,其可以被插入到增强现实头戴送受话器12中或者可移除地耦合(例如,能够反复分离和耦合)到增强现实头戴送受话器12。在一些实施例中,显示器20可以是增强现实头戴送受话器12的固定部件。此外,在附加或可替代实施例中,显示器20包括使用户10能够通过屏幕或透镜直接观看现实环境的透明或半透明屏幕或透镜。模拟的视觉环境然后可以结合可视的现实世界环境被叠加或以其他方式被显示。在一些实施例中,增强现实头戴送受话器12可以包括眼睛或瞳孔跟踪传感器26,其确定用户的眼睛或瞳孔的位置和/或发送指示用户的眼睛或瞳孔的位置的一个或多个信号。

图3是根据本公开的实施例的增强现实系统38的框图。如所图示,增强现实系统38包括具有控制器42的会聚调整系统40,该控制器42包括一个或多个处理器44和一个或多个存储器设备46。处理器44可以执行软件程序和/或指令以调整虚拟对象的显示。此外,处理器44可以包括多个微处理器、一个或多个“通用”微处理器、一个或多个专用微处理器、和/或一个或多个专用集成电路(ASICS)、和/或一个或多个精简指令集(RISC)处理器。存储器设备46可以包括一个或多个存储设备,并且可以存储机器可读和/或处理器可执行指令(例如,固件或软件)以供处理器44执行,所述指令诸如与调整虚拟对象的显示有关的指令。因此,存储器设备46可以存储例如控制软件、查找表、配置数据等,以促进调整虚拟对象的显示。在一些实施例中,处理器44和存储器设备46可以在控制器42的外部。存储器设备46可以包括有形的、非暂时性的、机器可读介质,诸如易失性存储器(例如,随机存取存储器(RAM))和/或非易失性存储器(例如,只读存储器(ROM)、闪速存储器、硬盘驱动器和/或任何其他合适的光学、磁性或固态存储介质)。

会聚调整系统40还可以包括动态地确定用户10的瞳孔间距离的瞳孔间距离确定引擎48。瞳孔间距离可以是用户的瞳孔之间的距离。在一些实施例中,瞳孔间距离确定引擎48可以从增强现实头戴送受话器12的瞳孔跟踪传感器26接收指示瞳孔间距离的信号。瞳孔间距离确定引擎48然后可以基于接收的信号确定瞳孔间距离。

在附加或可替代实施例中,瞳孔间距离确定引擎48可以基于校准过程来估计瞳孔间距离。也就是说,当用户10首次装备增强现实头戴送受话器12时,会聚调整系统40的控制器42可以执行校准过程。校准过程可以包括在不同的虚拟深度处显示多个虚拟对象,并且当用户10看到相应虚拟对象的单个图像相对双重图像时提示用户10来响应。通过将用户的眼睛的估计位置与在其处显示虚拟对象的不同虚拟深度进行三角测量,可以使用与看到单个图像对应的用户的响应来估计用户的眼睛的位置。瞳孔间距离确定引擎48可以基于用户的眼睛的估计位置来确定不同虚拟深度处的瞳孔间距离的集合。因此,可以保存瞳孔间距离确定,并且瞳孔间距离确定引擎48可以执行回归分析或任何其他合适形式的估计分析以生成数学模型或表达式,该数学模型或表达式基于保存的瞳孔间距离确定的集合来预测取决于虚拟对象的虚拟深度的瞳孔间距离。瞳孔间距离确定引擎48可以动态地确定或估计用户10的瞳孔间距离,因为瞳孔间距离可以在用户10观看不同对象(虚拟或现实)时改变。因此,不断地、周期性地或在某些时间或兴趣点(例如,当显示不同的虚拟对象或现实对象进入视野时)更新用户10的瞳孔间距离可以是有用的。应当理解的是,如在本公开中使用的术语“引擎”可以包括硬件(诸如电路)、软件(诸如存储在存储器设备46中以供由处理器44执行的指令)或两者的组合。例如,瞳孔间距离确定引擎48可以包括瞳孔跟踪传感器26和耦合到瞳孔跟踪传感器26的电路,其从瞳孔跟踪传感器26接收瞳孔跟踪信息并基于瞳孔跟踪信息确定用户10的瞳孔间距离。

会聚调整系统40还可以包括显示调整引擎50,其基于用户10的瞳孔间距离调整虚拟对象的显示和/或提供对虚拟对象的显示的调整。特别地,显示调整引擎50可以接收输入图像数据52,其可以包括一个或多个虚拟对象54。每个虚拟对象54可以在相应虚拟深度处被显示。显示调整引擎50还可以接收如由瞳孔间距离确定引擎48确定的瞳孔间距离。显示调整引擎50然后可以基于瞳孔间距离调整每个虚拟对象54的显示。

在一些情况下,会聚调整系统40可以是增强现实头戴送受话器12的部分。在附加或可替代实施例中,会聚调整系统40可以在增强现实头戴送受话器12的外部,并且经由任何合适的通信网络和/或协议与增强现实头戴送受话器12通信。例如,增强现实头戴送受话器12和会聚调整系统40中的每个可以包括通信接口,并且通信接口可以连接到通信网络。通信网络可以是有线和/或无线的,诸如移动网络、WiFi、LAN、WAN、英特网和/或类似物,并且使增强现实头戴送受话器12和会聚调整系统40能够彼此通信。

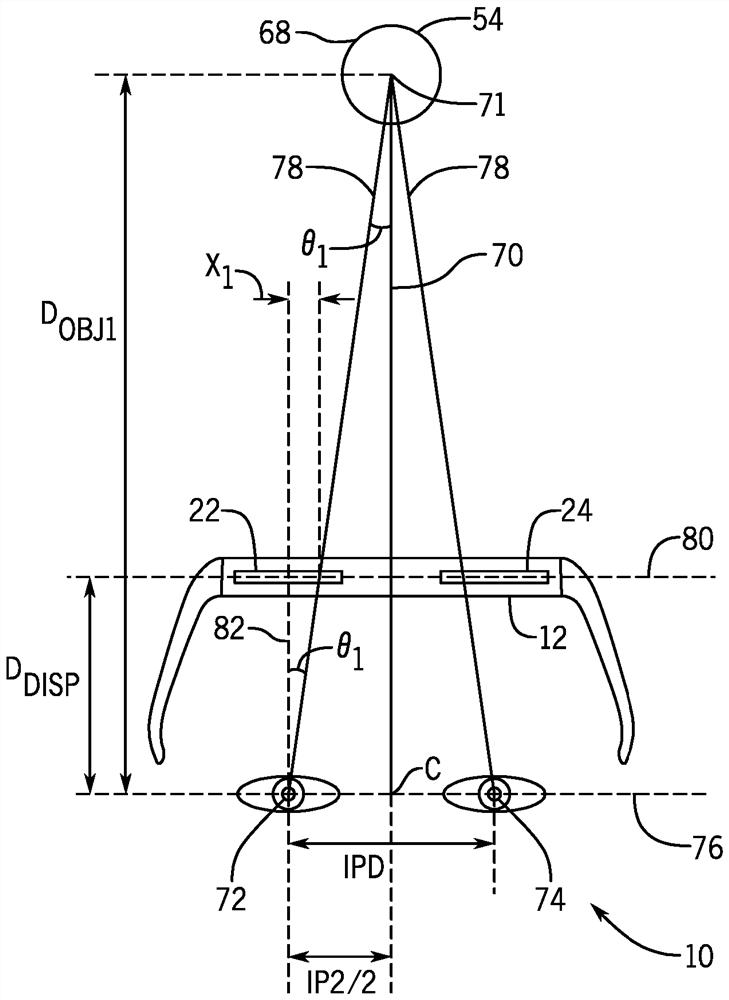

作为示例,图4是根据本公开的实施例的用户10通过增强现实头戴送受话器12观看虚拟对象54的示意性平面视图。虚拟对象54被显示在虚拟位置68和一虚拟深度处,该虚拟深度模拟沿着中心线70的虚拟距离D

用户的瞳孔72、74之间的瞳孔间距离沿着穿过用户的瞳孔72、74的瞳孔间线76被指示为图4中的IPD,以及中心点C和用户的瞳孔70、72中的任一个之间的、沿着瞳孔间线76的距离被指示为图4中的IPD/2。附加地,如图4中所示,用户的瞳孔72、74中的任一个和虚拟对象54之间的注视线或会聚向量78与中心线70成角度θ

图5是根据本公开的实施例的通过增强现实头戴送受话器12正在被观看的图4的虚拟对象54的用户的视角的示意性表示。会聚调整系统40的控制器42将虚拟对象54显示为左显示器22上左边位置101处的左虚拟对象100以供用户的左眼观看,以及显示为右显示器24上右边位置103处的右虚拟对象102以供用户的右眼观看。增强现实头戴送受话器12将虚拟对象54显示为表现为在用户10的正前面(例如,沿着图4的中心线70)。因此,控制器42可以显示比起外侧(例如,最左)边缘108更靠近左显示器22的内侧(例如,最右)边缘106的左虚拟对象100的参考点(例如,中心)104,并且可以显示比起外侧(例如,最右)边缘114更靠近右显示器24的内侧(例如,最左)边缘112的右虚拟对象102的参考点(例如,中心)110。此外,虚拟对象100、102的参考点104、110可以离开每个显示器22、24的内侧边缘106、112相等距离Y

作为进一步示例,图6是根据本公开的实施例的在图4的虚拟对象54改变深度时的用户10通过增强现实头戴送受话器12观看图4的虚拟对象54的示意性平面视图。特别地,会聚调整系统40的控制器42可以看来似乎将虚拟对象54的深度从模拟沿着中心线70的第一虚拟距离D

在虚拟对象54改变深度时,用户的瞳孔72、74中的任一个和在第一虚拟距离D

因此,瞳孔由于虚拟对象54的深度的改变而在显示线80处移动的距离可以表达为沿着显示线80的显示距离线82和注视线78之间的距离(例如,X

因为图6中图示的改变深度的示例将虚拟对象54从较靠近的深度移动到较远离的深度,所以沿着显示线8 0的对应于较靠近的深度的显示距离线82和注视线78之间的距离(例如,X

图7是根据本公开的实施例的在虚拟对象改变深度时的当通过增强现实头戴送受话器12观看时图6的虚拟对象54的用户的视角的示意性表示。会聚调整系统40的控制器42在左显示器22上显示从原始左边位置101移动到第二左边位置140的左虚拟对象100以供用户的左眼观看,并在右显示器24上显示从原始右边位置103移动到第二右边位置142的右虚拟对象102以供用户的右眼观看。增强现实头戴送受话器12将虚拟对象54显示为表现为用户10的正前面(例如,沿着图6的中心线70)。因此,控制器42可以显示比起外侧(例如,最左)边缘108更靠近左显示器22的内侧(例如,最右)边缘106的(在第二左边位置140处的)左虚拟对象100的参考点(例如,中心)144,并且可以显示比起外侧(例如,最右)边缘114更靠近右显示器24的内侧(例如,最左)边缘112的(在第二右边位置142处的)右虚拟对象102的参考点(例如,中心)146。此外,(在第二左边位置140和第二右边位置142处的)虚拟对象100、102的参考点144、146可以离开每个显示器22、24的内侧边缘106、112相等距离Y

为了确定从每个显示器22、24的内侧边缘106、112到左虚拟对象100和右虚拟对象102的参考点144、146的距离Y

因此,控制器42可以将虚拟对象100、102显示为离开一位置差X

针对多个虚拟对象54,控制器42可以确定沿着显示线80的对应于较靠近深度的显示距离线82和注视线78之间的距离(例如,X

此外,如所图示,控制器42缩小第二位置140、142处的虚拟对象100、102以使虚拟对象100、102似乎比当虚拟对象100、102在它们的相应原始位置101、103时离开更远。在控制器42看来似乎使虚拟对象100、102从较远离的深度移动到较靠近的深度的情况下,控制器42可以代替地从当虚拟对象100、102在它们的相应原始位置101、103时放大虚拟对象100、102。

横向距离X

图8是根据本公开的实施例的用于调整虚拟对象54的显示的过程160的流程图。特别地,会聚调整系统40可以实施过程160来调整虚拟对象54的显示。过程160可以具有一个或多个软件应用的形式,该软件应用包括由至少一个合适的处理器(诸如控制器42的处理器44)经由瞳孔间距离确定引擎48和/或显示器调整引擎50执行的指令。所图示的过程160仅作为示例提供,并且在其他实施例中,根据本公开,过程160的某些所图示的步骤可能以其他顺序执行、被跳过、被重复或未示出。

如所图示,在过程块162中,处理器44接收一个或多个显示对象要被显示为从第一深度移动到第二深度的指示。例如,处理器44可以确定显示器20正在显示一个或多个虚拟对象54。处理器44可以接收输入图像数据52,其可以包括改变深度的一个或多个虚拟对象54。因此,处理器44可以确定一个或多个虚拟对象54正在将它们的相应深度从相应第一深度改变成相应第二深度。在附加或可替代实施例中,处理器44可以接收直接指示一个或多个虚拟对象54正在改变它们的相应深度的一个或多个输入信号(例如,一个或多个改变深度指示信号)。参考图6,处理器44可以接收虚拟对象54正在将深度从第一深度处的第一位置68改变成第二深度处的第二位置128的指示。

在过程块164中,处理器44确定用户的瞳孔间距离。例如,处理器44可以从图3中所示的瞳孔跟踪传感器26接收瞳孔位置信息,并指示瞳孔间距离确定引擎48基于瞳孔位置信息确定瞳孔间距离(例如,如图4中所示的IPD)。在附加或可替代实施例中,处理器44可以指示瞳孔间距离确定引擎48基于校准过程和/或执行回归分析或任何其他合适形式的估计分析来估计瞳孔间距离。也就是说,处理器44可以在显示器20上显示不同虚拟深度处的多个虚拟对象,并且提示用户10在用户10看到相应虚拟对象的单个图像相对双重图像时做出响应。通过将用户的眼睛的估计位置与在其处显示虚拟对象的不同虚拟深度进行三角测量,可以使用与看到单个图像对应的用户的响应来估计用户的眼睛的位置。处理器44可以基于用户的眼睛的估计位置来确定不同虚拟深度处的瞳孔间距离的集合。可以保存瞳孔间距离确定,并且处理器44可以执行回归分析或任何其他合适形式的估计分析以生成数学模型或表达式,该数学模型或表达式基于保存的瞳孔间距离确定的集合来预测取决于虚拟对象的虚拟深度的瞳孔间距离。瞳孔间距离确定引擎48可以动态地确定或估计用户10的瞳孔间距离,因为瞳孔间距离可以在用户10观看不同对象(虚拟或现实)时改变。因此,不断地、周期性地或在某些时间或兴趣点(例如,当显示不同的虚拟对象或现实对象进入视野时)更新用户10的瞳孔间距离可能是有用的。

在过程块166中,处理器44基于瞳孔间距离确定沿着显示器的与在第一深度处的所显示对象相关联的第一会聚向量和与在第二深度处的所显示对象相关联的第二会聚向量之间的横向距离。参考图6,第一会聚向量或注视线78与第一深度处的第一位置68处的虚拟对象54相关联。第二会聚向量或注视线130与第二深度处的第二位置128处的虚拟对象54相关联。

横向距离X

在判定块168中,处理器44确定是否存在另一个要被显示为从相应第一深度移动到相应第二深度的所显示对象。如果是,则处理器44重复过程块166以基于瞳孔间距离确定沿着显示器20的与在相应第一深度处的附加虚拟对象相关联的第一会聚向量和与在相应第二深度处的附加虚拟对象相关联的第二会聚向量之间的横向距离X

如果处理器44确定不存在另一个要被显示为从相应第一深度移动到相应第二深度的所显示对象,则处理器44在过程块170中基于相应横向距离将每个所显示对象显示为从相应第一深度移动到相应第二深度。特别地,处理器44可以将显示器22、24上显示的每个虚拟对象100、102的参考点144、146移位横向距离X

本文中呈现和要求保护的技术被引用和应用于材料对象和实际性质的具体示例,其确然地改进了本技术领域,并且因此不是抽象的、无形的或纯粹理论的。此外,如果附到本说明书结尾的任何权利要求包含一个或多个被指定为“用于[执行]……[功能]的装置”或者“用于[执行]……[功能]的步骤”的元件,则旨在要根据35 U.S.C. 112(f)来解释这样的元件。然而,对于包含以任何其他方式指定的元件的任何权利要求,旨在不要根据35U.S.C. 112(f)来解释这样的元件。

- 虚拟现实头戴送受话器中的动态会聚调整

- 可变换成头戴送受话器的电话送受话器