一种基于联邦偏好学习的空间众包任务分配方法

文献发布时间:2023-06-19 18:34:06

技术领域

本发明涉及信息技术领域,尤其涉及一种基于联邦偏好学习的空间众包任务分配方法。

背景技术

空间众包在当今的网络世界中无处不在。过去十年见证了空间众包的巨大进步,它使人们能够借助多模态传感器去执行各种基于位置的任务。空间众包提出的社会和伦理问题越来越受到关注,包括隐私和效率等问题。其中,隐私是空间众包中最常见的问题之一。为了实现有效的空间众包服务,工人或平台中心(例如,公司的交付中心)通常需要披露其原始信息(如,工人的位置和历史数据)。但是,真实数据若被恶意第三方利用,这不仅很危险,还会让人们更不愿意将其数据交付于空间众包平台,从而导致低用户参与度与用户流失。

因此,不少研究开始关注空间众包中的隐私保护问题,比如通过工人位置数据扰动、加密或者距离计算的加密操作来保护工人的位置信息。但是,它们往往只考虑了工人位置信息的保护问题,而忽略了工人偏好,而大多不考虑工人是否对任务感兴趣的分配方法可能导致工人拒绝执行任务或低质量地完成任务。因而,此类研究无法保证现实中高质量的任务分配,不具有可行性。

此外,现存的研究方法中有不少关注于各个因素对任务分配的影响,如工人们的拒绝率、工人技能、平台利润等因素以提高系统可行性。但是,以工人的偏好因素为例,无论是单个工人的任务分配问题还是群组任务分配问题,这些方法均通过建立各种复杂的偏好模型,对所有工人的历史数据与外部数据进行集中训练,从而获取全局的工人偏好。但是,在现实生活的场景里,存在数据孤岛问题,并且模型集中训练的方式需要,这将无法做到对工人数据的保护。

因此,现存的方法均有一些不同的缺陷,即它们无法在一定程度上保护工人数据的情况下获取全局的工人偏好。所以,以往的研究方法将不再适用。

发明内容

本发明的目的是要提供一种基于联邦偏好学习的空间众包任务分配方法。

为达到上述目的,本发明是按照以下技术方案实施的:

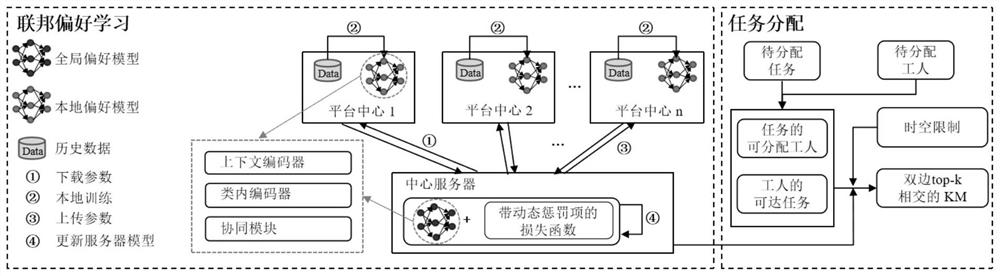

本发明包括联邦偏好学习阶段和任务分配阶段,所述联邦偏好学习阶段对本地偏好模型使用联邦学习进行模型训练,从而得到服务器中心端的最终偏好模型,进而得到全局工人的偏好;所述任务分配阶段通过基于KM的双边top-k相交的方法和任务再分配的方法对任务分配过程进行加速,并保证较高的任务分配数量及完成率。

进一步,所述本地偏好模型由上下文编码器模块、类内编码器模块和协同模块构建,所述上下文编码器模块获取包含任务序列上下文信息和任务类别信息,模型预测下一个任务的类别用来确定应该利用哪些类别内的工人偏好;所述类内编码器模块将进一步预测各类别内工人对下一个任务地点的偏好;所述协同模块获取相似工人的偏好来辅助预测目标工人的偏好。

本发明的有益效果是:

本发明是一种基于联邦偏好学习的空间众包任务分配方法,与现有技术相比,本发明能有效解决用户隐私保护导致的数据孤岛的问题。首先对存储在各平台中心的当地数据进行偏好建模。其中,本地偏好模型利用上下文编码器、类内编码器和协同模块得到工人对任务位置和任务类别的偏好。然后,本发明利用联邦学习框架,通过各平台中心的本地模型参数传递去更新中心服务器的模型参数,从而获取全局的工人偏好。最后,在考虑工人偏好的情况下,本发明将任务分配转化为二部图最大匹配问题,利用一种基于KM的双边top-k相交的方法对所建图的边集进行过滤,并使用再分配的方法对剩余任务进行二次分配,从而实现了在加速匹配算法的同时保证了分配任务总数。因此,本发明能够有效地获得高任务成功率和分配任务总数,并实现了多平台工人数据非集中情况下对任务偏好感知的工人任务分配,即在一定程度上保护了工人的隐私。

附图说明

图1是本发明基于联邦偏好学习的空间众包任务分配的总体架构图;

图2是本发明中平台中心的偏好模型。

具体实施方式

下面结合附图以及具体实施例对本发明作进一步描述,在此发明的示意性实施例以及说明用来解释本发明,但并不作为对本发明的限定。

如图1和2所示:本发明整个网络架构分为两个阶段:联邦偏好学习阶段和任务分配阶段。

在联邦偏好学习阶段,需要对本地偏好模型使用联邦学习进行模型训练,从而得到服务器中心端的最终偏好模型,从而得到全局工人的偏好。

在本地偏好模型的构建中,模型主要由三个模块构成,分别是上下文编码器模块、类内编码器模块和协同模块。

首先,上下文编码器用来获取包含任务序列上下文信息和任务类别信息。模型预测下一个任务的类别用来确定应该利用哪些类别内的工人偏好。

为了获取类别上下文信息,该模块使用了top-k门控网络。对于top-k门控网络而言,将工人近期的任务类别序列作为输入,结合类别嵌入层与位置嵌入层分别映射得到嵌入向量X

然后,top-k门控网络生成一个对所有任务类别的概率分布:

其中,

其中,所选前k个任务类别c

为了捕获隐藏在最近任务记录中的任务序列上下文信息,该模块还采用了近期行为编码器。类似地,近期行为编码器将工人近期的任务序列作为输入,结合任务地点嵌入层与位置嵌入层分别映射得到嵌入向量X

然后,在得到所预测的k个任务类别

接着,为了缓解交互数据的稀疏性,利用协同模块可以获取相似工人的偏好来辅助预测目标工人的偏好。其中,给定目标工人w的类内偏好

之后,选取top-f个相似工人的向量表示进行加权求和,作为最终的相似工人的类内偏好的向量表示

其中,top-f个相似工人的选取范围是该类别下最近活动的F个工人。

基于上述三个模块,利用得到的任务序列上下文信息、任务类别信息和类内偏好信息可以获取目标工人对任务地点和任务类别的偏好。目标工人对任务类别c

其中,

为了预测标工人对任务地点l

其中,

通过如下计算可以得到类别j下,工人对任务地点l

其中,E

当考虑所有top-k个类别时,则目标工人对任务地点l

各平台中心的本地偏好模型构建完成后,将对其使用联邦学习进行模型训练,且联邦学习中的损失函数l(θ)可以表示为:

其中,m表示所选的平台中心数量,L

其中,θ表示偏好模型的参数集合,L

为了加速任务地点预测损失的计算,对于每个真实的任务地点,根据任务地点的流行度,随机采取N

其中,δ(·)是一个指示函数,l

类似地,可以计算出损失函数L

在具体的联邦训练过程中,每轮t将重复以下操作:首先,对所有平台中心进行采样得到参与训练的平台中心集合P

本地训练结束后,每个参与训练的平台中心将本地更新的参数

在任务分配阶段,提出一种基于KM的双边top-k相交的方法和任务再分配的方法对任务分配过程进行加速,并保证较高的任务分配数量及完成率。

首先,本算法通过建立工人与任务的二部图,将任务分配问题转化为二部图最大权重匹配问题。建立的二部图中的点集分为V

(1)时空限制:w

(2)top-k限制:

其中,AW(s

(1)d(w.l,s.l)≤w.r

(2)t

上述两个条件分别表示:任务s需要在工人w的可达范围之内;工人需要在任务过期之前到达执行地点。

从工人

其中,

为了更好地实现该任务分配算法,算法在递归寻找工人可匹配的任务的函数中限制递归深度为k。同时,该函数计算了两个顶点相关联的边的权重与工人和任务的期望值之和的差值。如果该差值等于0,则可以将任务分配给工人。其中工人和任务的期望值为与其关联的边中的最大权重值。当工人未能匹配到任何一个任务时,则将调整上一次匹配中涉及的工人和任务的期望,改变工人之间的竞争关系,以达到分配更多工人的目的。此外,由于工人任务二部图可能不存在完美匹配的实际情况,对于期望值小于0的工人,我们将停止为该工人匹配任务。

由于建立二部图的边集时,top-k限制极大地过滤了很多低权重的边,会导致较大的任务分配数量损失。因此,本算法还包含了任务再分配的方法以对该损失进行弥补,即当存在未分配且仍有可用工人的任务时,将其分配给对它偏好最大的可用工人。

本发明所具有的优势为:各平台中心在不直接传输数据的情况下,通过联邦偏好学习对工人任务偏好进行有效的建模,并结合一种基于KM的双边top-k相交的方法和任务再分配的方法极大地加速了任务分配过程,并保证了较高的任务分配数量及完成率。

首先,本发明对存储在各平台中心的本地数据进行偏好建模。本地偏好模型中,利用上下文编码器、类内编码器和协同模块分别可以得到工人-任务序列中的上下文信息、工人对任务地点的偏好和相似工人的任务地点偏好。而后,结合上述三种所得信息并通过全连接网络可以得到工人对任务位置和任务类别的偏好。然后,为了保护各平台中心的数据隐私,本发明利用联邦学习框架,通过传递各平台中心的本地模型参数去更新中心服务器的模型参数,从而获取全局的工人偏好。最后,在考虑工人偏好的情况下,本发明将任务分配转化为二部图最大匹配问题,利用一种基于KM的双边top-k相交的方法对所建图的边集进行过滤。相比原始KM和单边top-k的方法,本发明保证了快速且高质量的任务分配。同时,本发明使用再分配的方法对剩余任务进行二次分配,从而保证了较高的分配任务总数。因此,本发明能够有效地获得高任务成功率和分配任务总数,并实现了多平台工人数据非集中情况下对任务偏好感知的工人任务分配,即在一定程度上保护了工人的隐私。

本发明的技术方案不限于上述具体实施例的限制,凡是根据本发明的技术方案做出的技术变形,均落入本发明的保护范围之内。

- 一种基于目的地的空间众包任务分配方法

- 一种基于互信息和偏好感知的空间众包任务分配方法

- 一种基于空间众包社交影响偏好的组任务分配方法